Costretti a convivere con una miriade di armi nucleari – molte delle quali pronte a venir lanciate nel giro di pochi minuti – dobbiamo augurarci che gli sviluppi militari attualmente in corso almeno non compromettano il presente delicato stato di stabilità strategica a evitarci il rischio di un confronto nucleare in uno dei vari fronti caldi delle attuali tensioni mondiali.

Il concetto di stabilità strategica comprende due aspetti: la stabilità in situazioni di crisi e la stabilità rispetto alla corsa agli armamenti. Si richiede che anche durante una crisi internazionale, ovvero un conflitto convenzionale, gli stati coinvolti non intensifichino il conflitto fino alla prospettiva dell'uso di armi nucleari (nuclear escalation). Ciò comporta per le parti implicate un atteggiamento di "non uso per primi" delle armi nucleari, ma anche che la situazione sia robusta a fronte di un'escalation nucleare involontaria o dovuta a informazioni errate ovvero a guasti dei sistemi di comando e controllo.

Una corsa agli armamenti si evita quando le parti in conflitto hanno incentivi a evitare cicli di azione-reazione militari, che potrebbero anche portare a favorire strategie miranti ad attacchi nucleari disarmanti (first-strike capability) o a degradare le forze di reazione dell'avversario.

“ Un grave fattore di rischio strategico viene dall'attuale confronto fra Cina, Russia e Stati Uniti

Un grave fattore di rischio strategico viene dall'attuale confronto fra Cina, Russia e Stati Uniti per raggiungere la superiorità nei campi scientifici più avanzati: volo ipersonico, sistemi spaziali, biotecnologie, gestione di enormi masse di dati, sistemi d'arma autonomi letali, robotica, armi a energia diretta, tecnologia quantistica e, in primis, l'intelligenza artificiale (AI), che entra in molte altre tecnologie come componente essenziale o potenziante.

I recenti significativi sviluppi dell'intelligenza artificiale, nella forma di apprendimento automatico (machine learning ML), hanno rinnovato l'attenzione anche per applicazioni in ambito militare, sia per armamenti strategici che tattici, e vari ricercatori stanno indagando appunto sui rischi che può comportare una massiccia introduzione di automatismi e intelligenza artificiale nei sistemi strategici.

Intelligenza artificiale, apprendimento automatico e autonomia

L'intelligenza artificiale viene intesa popolarmente come la capacità di calcolatori o robot di uguagliare – se non superare – gli esseri umani nello sviluppare una comprensione operativa dell'ambiente. Un'AI di questo genere è alla base della letteratura e del cinema di fantascienza, ma è ritenuta dalla maggior parte degli esperti una sfida tecnologica impossibile.

Una caratterizzazione più realistica e affrontabile si basa sul concetto di AI come "la scienza e l'ingegneria per costruire macchine in grado di compiere cose che richiederebbero intelligenza se fatte da uomini". In pratica attualmente consiste in complessi programmi software che possono eseguire precisi compiti "intelligenti", come riconoscere oggetti o esseri viventi dalle immagini, interpretare segnali di vario tipo, individuare situazioni anomale, tradurre linguaggi o elaborare strategie per giochi.

Fra i molteplici approcci tecnologici per lo sviluppo di vari livelli di AI, attualmente è particolarmente sviluppato l'apprendimento automatico (ML), basato su una varietà di tecniche matematiche: metodi algoritmici, apprendimento statistico, teoria dell'ottimizzazione, teoria dei giochi, reti neurali, ...; dopo una fase di "apprendimento" basata sulla presentazione di classi selezionate di dati annotai o classificati e la definizione di regole sulle relazioni tra i dati stessi, al sistema si richiede di estrarre informazioni da una varietà di dati "reali" della stessa classe per risolvere problemi specifici o proporre previsioni. I sistemi di ML possono migliorare le prestazioni nel tempo poiché i modelli creati si adattano a nuovi dati senza che un essere umano programmi esplicitamente nuove regole.

L'apprendimento automatico è utile per trovare connessioni tra i dati, il che lo rende uno strumento potente per automatizzare qualsiasi attività che richieda un riconoscimento di strutture e di segnali (visivi, sonori o elettromagnetici). Le attività di gestione dei dati possono includere classificazione, analisi predittiva, rilevamento di anomalie, individuazione di falsi positivi/negativi, manipolazione, generazione di dati sintetici e ottimizzazione, tracciamento di connessioni precedentemente inimmaginabili.

Tutte queste capacità trovano un'ampia portata in ambito militare: per migliorare le prestazioni dei sistemi di gestione dei dati per intelligence, sorveglianza e ricognizione (ISR), logistica e manutenzione, sicurezza e difesa da attacchi cibernetici, gestione della battaglia, addestramento, modellizzazione e simulazione; per potenziare le capacità percettive di qualsiasi sistema militare aumentando la possibilità che funzioni in modo autonomo in un ambiente dinamico e non strutturato; per permettere nuove forme di operazioni, come il coordinamento di molti (o moltissimi) sistemi autonomi (swarming) per obiettivi specifici.

La vulnerabilità e la limitazione dell'apprendimento automatico dipendono dalla sua relazione con i dati: i suoi algoritmi sono validi solo quanto lo sono i dati su cui il sistema ML è stato addestrato. Se l'insieme dei dati di addestramento non è rappresentativo e privo di pregiudizi (i dati non sono quasi mai "neutri" o neutralizzabili), il sistema potrebbe fallire, funzionare male o dare informazioni errate o viziate da pregiudizi. Ciò rappresenta una sfida critica per lo sviluppo di applicazioni nel contesto militare.

Il fatto che le macchine apprendano trovando relazioni statistiche all'interno dei dati rende il loro funzionamento opaco e il loro comportamento potenzialmente imprevedibile. I sistemi di apprendimento automatico funzionano come una scatola nera: l'input e l'output del sistema sono osservabili, ma il processo computazionale che porta dall'uno all'altro è difficile da capire per gli stessi progettisti del sistema, creando problemi di prevedibilità. Si è visto che impercettibili perturbazioni dei dati portano a errori clamorosi, per esempio nel riconoscimento di oggetti o esseri viventi. Nel contesto dei sistemi d'arma, questa imprevedibilità potrebbe ovviamente avere conseguenze drammatiche.

Va tenuto presente che i sistemi di AI, sebbene possano superare gli esseri umani per molti compiti, non percepiscono le strutture a livello astratto, non hanno un modo naturale per affrontare struttura gerarchiche, né sono in grado di distinguere fra causalità e correlazione, e, soprattutto, mancano assolutamente del "buon senso", che invece si rivelato spesso cruciale nel confronto strategico per evitare situazioni estreme e rischi gravissimi.

L'apprendimento automatico può essere impiegato per accrescere l'autonomia di una macchina, o di un sistema, la capacità di eseguire uno o più compiti senza intervento umano, utilizzando le interazioni della programmazione del computer con l'ambiente. Un sistema robotico autonomo può eseguire alcune attività molto più velocemente di quanto possa mai fare un qualsiasi essere umano o un apparato azionato da esseri umani; ciò è particolarmente attraente per le forze armate in compiti in cui il tempo è un fattore critico come, ad esempio, per la difesa aerea o contro attacchi cibernetici.

L'autonomia può ridurre la necessità di mantenere un collegamento di comunicazione costante tra il robot e il comando militare, come invece è attualmente necessario con i sistemi controllati a distanza. L'autonomia è particolarmente utile anche per le cosiddette missioni noiose, sporche e pericolose (3D) in quanto rimuove i limiti che possono degradare le prestazioni umane. Garantisce l'accesso a teatri operativi altrimenti inaccessibili ai sistemi telecomandati o troppo rischiosi: aree protette da sistemi contro-intervento, anti-accesso e controllo d’area (A2/AD), acque profonde, l'Artico e lo spazio esterno. Infine, l'autonomia fornisce anche nuove opportunità per le operazioni collaborative in quanto consente ai sistemi d'arma di operare in grandi gruppi, o "sciami", in un modo molto più coordinato, strutturato e strategico che se ciascuno fosse controllato individualmente da un operatore umano.

“ Vari ricercatori stanno indagando appunto sui rischi che può comportare una massiccia introduzione di automatismi e intelligenza artificiale nei sistemi strategic

Precedenti durante la guerra fredda

Sistemi con vari livelli di automazione sono da decenni presenti anche negli armamenti nucleari, in particolare negli apparati di allerta precoce, nei sistemi nucleari di comando, controllo e comunicazione (NC3), e nei sistemi di difesa anti-aerea e anti-missile, nonché nei vettori (aerei, missili) delle armi.

Un pilastro fondamentale della deterrenza nucleare durante la guerra fredda è stata l'esistenza in USA e URSS di forze nucleari in grado di sopravvivere a un primo attacco e infliggere danni di ritorsione inaccettabili per l'aggressore. Questo imperativo richiedeva lo sviluppo di sistemi resilienti di preallarme e di forme agili di comando e controllo che consentissero di identificare una minaccia e fornire una risposta adeguata entro un tempo limitato.

Già negli anni Sessanta si ricorse a una crescente automazione nei sistemi di comando e controllo, per la pianificazione logistica della trasmissione degli ordini di attacco, per il rifornimento in volo di bombardieri e per la guida dei missili verso il bersaglio. L'automazione del rilevamento delle minacce poteva fornire più rapidamente le informazioni radar ai responsabili delle decisioni e quindi dare loro più tempo per decidere se lanciare un contrattacco.

Tuttavia i responsabili delle decisioni nucleari sovietiche e statunitensi hanno subito identificato i limiti dell'automazione per la deterrenza nucleare: la tecnologia di rilevamento automatizzato durante la guerra fredda soffriva di numerosi problemi, di una rozza intelligenza percettiva, con errori e falsi allarmi. A causa di queste limitazioni, rimasero riluttanti a trasferire valutazioni di ordine superiore e capacità decisionali a sistemi automatizzati, e gli esseri umani rimasero sempre "nel circuito" del comando e controllo nucleare al fine di verificare e analizzare le informazioni fornite dai sistemi.

L'unica significativa applicazione di AI alla strategia nucleare si ebbe nel 1985, quando l'Unione Sovietica, ritenendo che gli Stati Uniti mirassero a una capacità di attacco nucleare disarmante, creò il sistema di rappresaglia semiautomatico Perimetr, noto in occidente come Dead Hand (mano morta), per garantire in ogni condizione una risposta sovietica a un attacco nucleare americano.

Per lanciare la ritorsione nucleare con i missili balistici (ICBM) sopravvissuti, il sistema avrebbe dovuto utilizzare una formula proposizionale "se-allora": se il sistema fosse stato attivato e se un'arma nucleare avesse colpito il suolo sovietico e se non ci fosse alcun collegamento per comunicare con la sala di crisi dello stato maggiore, allora il sistema avrebbe avviato il processo di lancio delle forze di ritorsione. Se il collegamento fosse rimasto operativo, il sistema avrebbe dovuto presumere che i responsabili mantenessero il pieno controllo decisionale e non farebbe nulla. Se il collegamento risultasse invece impossibile, il sistema avrebbe dedotto che questi responsabili non fossero più vivi e avrebbe trasferito l'autorità decisionale a chiunque fosse rimasto a gestire il sistema, che era ospitato in un bunker protetto in profondità. Nel sistema, il ruolo dell'AI era essenziale per poter desumere in modo autonomo che fosse avvenuto un attacco nucleare americano.

Il Perimetr ricorda la doomsday machine del film Dr. Stranamore, e, come nel film, gli USA non erano stati informati della sua esistenza, che, qualora nota agli avversari, avrebbe potuto costituire un potente sistema di dissuasione nucleare. Alcune fonti sostengono che il Perimetr sia attualmente in fase di potenziamento.

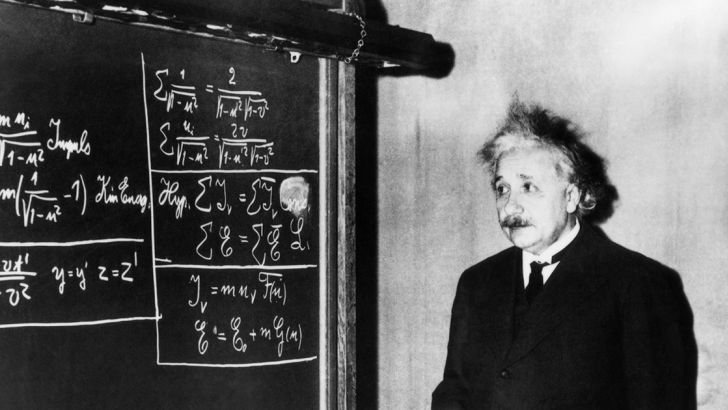

Una scena tratta dal film il dottor Stranamore

Da parte americana, per evitare l'impossibilità di comunicare con le basi missilistiche a causa della distruzione dei normali mezzi di comunicazione, venne creato un sistema di razzi segnaletici in grado di disseminare ai missili nucleari ordini di lancio pre-registrati. Verso la fine degli anni '80 gli USA lanciarono il progetto Survivable Adaptivre Planning Experiment (SAPE) impiegante tecnologie AI per individuare le basi mobili russe di missili intercontinentali e tradurre i dati raccolti in piani di attacco per i bombardieri B-2.

Un silos missilistico nell'ex URSS

Prospettive attuali

Le forze armate di tutti i maggiori paesi sono particolarmente impegnate allo sviluppo di capacità di ML e di automatismi a molteplici livelli, ma non si hanno informazioni pubbliche adeguate sull'effettiva introduzione di ML nell'attuale fase di ammodernamento degli armamenti. Poiché si tratta di una tecnologia abilitante così ampiamente pervasiva, l'impatto dell'IA sulla stabilità strategica risulterà sia diffuso che ampiamente variabile a seconda delle applicazioni.

Per quanto riguarda i sistemi strategici, nessuna potenza nucleare appare comunque incline ad affidare a computer la decisione dell'impiego di armi nucleari, sia perché esse si riservavano gelosamente questa prerogativa e perché automatizzare attacchi o ritorsioni non è una risposta logica ai delicatissimi problemi strategici coinvolti. Inoltre la potenza dei sistemi di ML resterà ancora a lungo lontana dal livello di capacità necessario per gestire la complessità di una guerra nucleare, anche perché c'è una totale mancanza di dati su cui istruire il sistema, dato che le armi nucleari non sono mai state utilizzate in conflitto dopo Hiroshima e Nagasaki; d'altra parte l'impiego di simulazioni, wargames ed esercitazioni creerebbe una base fortemente distorta, limitata e pregiudizievole.

Tuttavia i recenti progressi dei calcolatori e della cibernetica permettono drammatici incrementi nella visione automatica e in altre applicazioni del trattamento dei segnali per aumentare significativamente l'autonomia e l'integrazione dei sensori; questi elementi sono di fondamentale importanza strategica perché potrebbero migliorare notevolmente le capacità di ISR, riconoscimento automatico del bersaglio e di guida terminale delle armi.

Tutto ciò potrebbe erodere gravemente i mezzi a disposizione delle potenze nucleari per assicurare la sopravvivenza delle loro forze di ritorsione. L'aumento di accuratezza dei missili è andato minando la sicurezza dei silos degli ICBM e, conseguentemente, ha portato alla dispersione di parte delle forze nucleari: installate su mezzi mobili terrestri o su sottomarini, la loro posizione a un dato istante non è facilmente identificabile e quindi non possono venire prese di mira ed eliminate con successo.

Tuttavia, grazie all'AI, anche i missili mobili terrestri potrebbero perdere la loro occultabilità. Recentemente infatti si sta considerando un possibile scenario contro i sistemi mobili terrestri che si basa sulla fusione dell'AI con le tecniche di analisi di massicce quantità di dati nel contesto di un sistema di sorveglianza continua mediante costellazioni satellitari. Tale struttura mira appunto a monitorare in tempo reale la posizione delle piattaforme missilistiche mobili in qualunque punto del loro paese una volta lasciate le loro basi. A consentire una copertura quasi continua di vaste aree terrestri dovrebbe provvedere una costellazione di un gran numero ("sciame") di piccoli satelliti specializzati, opportunamente distribuiti e dotati dei necessari sensori per fornire una visione persistente in tutte le condizioni. Di fatto, la tecnica di sciami di centinaia o migliaia di piccoli satelliti è ormai matura per impieghi civili.

L'impiego di AI si rende necessario sia per il coordinamento e ottimizzazione degli sciami di satelliti che per l'analisi e l'interpretazione delle enormi quantità di dati che sarebbero restituite quasi in tempo reale dal monitoraggio continuo dell'intera rete stradale del paese avversario per individuare e seguire i veicoli dei missili mobili.

Naturalmente sono possibili varie forme di difesa dal sistema di sorveglianza, sia passive (mimetizzazione, moltiplicazione di civette sulle strade, utilizzo di tunnel, ...) che attive (attacchi cibernetici, disturbo dell'osservazione satellitare e delle comunicazioni), e difficilmente si potrebbe considerare l'informazione raccolta sicura ed esaustiva.

Ma a causa della gravità della potenziale minaccia alle forze di reazione del paese controllato che un tale sistema potrebbe rappresentare, anche se oggettivamente imperfetto e vulnerabile, esso sarebbe destabilizzante in situazioni di crisi: da una parte il paese osservato potrebbe ritenere necessario ricorrere a una dottrina di lancio su allarme per le forze mobili o addirittura a impiegarle immediatamente per evitarne la distruzione, dall'altra il paese osservante potrebbe ritenersi in grado di lanciare un attacco preventivo disarmante.

Il sistema favorisce anche una corsa agli armamenti: il paese osservato può cercare di ristabilire lo stato di deterrenza creando una ridondanza di armi, moltiplicando le forze missilistiche mobili o sviluppando nuovi sistemi nucleari non intercettabili, come ad esempio veicoli ipersonici o sottomarini autonomi, come il Poseidon (Status-6) russo. Questi sviluppi verrebbero subito contrastati da altri sistemi offensivi da parte del paese osservante, in una spirale di aumenti quantitativi e qualitativi delle forze nucleari.

Altri scenari di apprendimento automatico sono stati considerati per accrescere l'efficacia di sistemi nucleari (o creare nuove possibilità) in vari contesti strategici o tattici; spesso queste applicazioni risultano destabilizzanti, specialmente qualora rafforzino asimmetrie esistenti fra stati con armi nucleari.

Al di là dello studio delle applicazioni in progetti ambiziosi, occorre che i responsabili (e la comunità degli analisti indipendenti) valutino con attenzione i vantaggi e i rischi dell'incorporazione di ML nei processi di modernizzazione a breve termine nei vari settori militari nucleari e nell'infrastruttura logistica sottostante. Tali processi potrebbero plasmare la prossima generazione di armi e di strategie nucleari in una nuova rivoluzione negli affari militari. Tutti gli attori devono aver ben chiaro che l'incorporazione di intelligenza artificiale in sistemi nucleari può introdurne nuove vulnerabilità, tenuto in particolare conto che non esiste al momento un metodo sicuro per testare e verificare la sicurezza e affidabilità dell'apprendimento automatico.

Nel secolo scorso Russia e USA affrontarono importanti sviluppi tecnologici per gli armamenti nucleari con una seria politica di controllo degli armamenti. È difficile, se non impossibile, immaginare un sistema di monitoraggio e di ispezioni efficace per controllare mediate accordi internazionali i potenziali effetti destabilizzanti delle tecnologie di AI, per varie ragioni: la loro natura intrinseca di sistemi informatici complessi, per l'enorme diffusione in sistemi civili e militari, l'altissimo tasso di progresso, la segretezza mantenuta su specifiche applicazioni e il fatto che la forza che guida lo sviluppo del settore sono gli interessi del settore commerciale.

Tuttavia, sarebbe necessaria una maggiore trasparenza per ridurre malintesi e incomprensioni fra gli stati con armi nucleari su questioni relative all'impiego di tecniche di AI, sviluppando varie forme di misure miranti all'aumento di fiducia reciproca. Appare di interesse comune delle potenze nucleari cooperare per risolvere alcuni dei problemi –quali la sicurezza e la protezione dell'AI– che rendono altamente problematico l'uso di tecniche di AI nell'ambito nucleare.

Purtroppo sembra che ogni forma di progresso scientifico, in qualsiasi campo, finisca per fornire nuove potenzialità alle armi più pericolose, in primis quelle nucleari, e a indebolire il sistema di sicurezza globale e che questo possa avvenire in un modo ambiguo e con modalità che rendono difficile, se non impossibile, un'efficace forma di controllo o limitazione.