Un lanciarazzi BM21U in dotazione all'esercito ucraino. Foto: Reuters/Sofiia Gatilova

Si chiama Major Combat Operations Statistical Model (MCOSM) ed è stato sviluppato dal Naval War College e dalla Naval Postgraduate School di Monterey, in California, due degli istituti di educazione e ricerca della marina militare americana. Quando lo scorso febbraio hanno dato in pasto al modello i dati sul tentativo russo di conquistare rapidamente Kyiv, il responso è stato piuttosto chiaro. In una scala da uno a sette, ha assegnato due alle forze attaccanti e cinque alla difesa, un risultato che è stato confermato poi sul campo dallo svolgimento degli eventi.

Tentativi di prevedere l’esito di battaglie e situazioni di guerra con l’ausilio della scienza esistono almeno dagli anni Venti del Novecento, quando il matematico Lewis Fry Richardson applicò la statistica allo studio delle cause di un conflitto. Oggi sono i software e gli algoritmi basati sull’intelligenza artificiale a dominare la scena. L’idea, esattamente come per Richardson un secolo fa, è di minimizzare il costo di vite umane e risorse nello scontro armato, oltre che migliorare le decisioni su quando e come intervenire.

Tentativi di previsione

Un recente approfondimento dell’Economist racconta quali siano gli sforzi dei militari americani. Oggi esistono vari simulatori che si applicano alle diverse situazioni e ai diversi corpi dell’esercito, ma il punto più delicato è comprendere con quali dati alimentare gli algoritmi per ottenere risultati accurati. MCOSM, per esempio, è stato alimentato con i dati di 96 conflitti tra la fine della Prima Guerra mondiale e i giorni nostri. I risultati sono stati incoraggianti, come nel caso dell’assedio di Kyiv, ma siamo ancora lontani dalla possibilità di fare previsioni in tempo reale mentre le truppe sono effettivamente ingaggiate in un conflitto. MCOSM, per esempio, è un sistema cosiddetto “deterministico”, cioè se si lancia più volte la simulazione a partire dagli stessi dati si ottiene sempre lo stesso risultato.

Ma esistono anche sistemi predittivi probabilistici che tengono conto, per esempio, della possibilità che un colpo di fucile colpisca o meno il bersaglio, lo ferisca o lo uccida. Gli scenari possibili, quindi, diventano molti di più e più variegati. Se aggiungiamo a questi fattori le modifiche costanti della situazione sul campo - dati meteorologici, effettivo successo di un’operazione, arrivo dei rifornimenti, ecc. - si capisce come si tratti di un campo complesso in cui sviluppare un simulatore affidabile. Gli Stati Uniti ci stanno comunque provando, come attestano i diversi tentativi in sviluppo da parte di forze militari americane e i diversi fornitori raccontati dall’Economist.

Prevenire è meglio che intervenire

Esiste un altro approccio alla materia, reso negli ultimi anni famoso nell’ambiente dell’intelligenza artificiale da un articolo pubblicato nel 2018 su Nature. Gli autori sono tre esponenti di istituti di ricerca britannici: il politologo Kristian Gleditsch (Università dell’Essex), Weisi Gui (Università di Warwick) e Alun Wilson (Alan Turing Institute). La loro idea, sulla scia di quanto proponeva Richardson, è di sviluppare algoritmi in grado non di predire qual è il risultato di un conflitto armato, ma di indicare quando sta per scoppiare. In questo modo, dicono i tre, si potrebbe davvero minimizzare il costo della guerra perché si eviterebbe proprio di arrivarci. Per questo, propongono di creare un consorzio sovranazionale che provi a sviluppare questo tipo di modelli, per il bene dell’umanità.

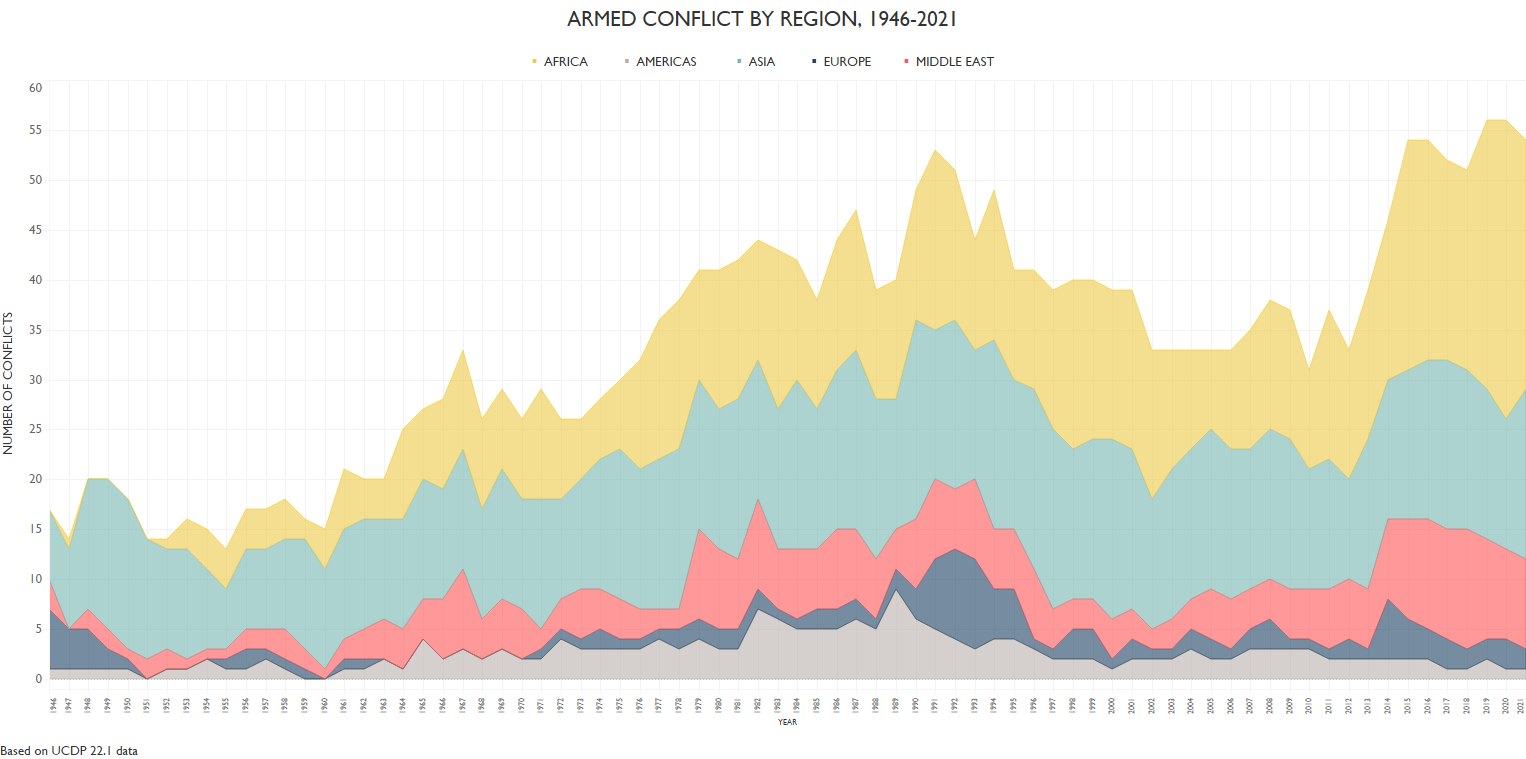

La consapevolezza del costo delle guerre, sostenevano nel 2018 Gleditsch, Gui e Wilson, è piuttosto limitata, soprattutto nella popolazione occidentale per cui i conflitti armati sono lontani. In parte questa consapevolezza sembra essere, almeno momentaneamente, cambiata a causa di un conflitto così grave come quello russo-ucraino in territorio europeo. Ma se osserviamo i dati raccolti dall’Uppsala Conflict Data Program, vediamo come il costo dei conflitti dal 1946 al 2021 è aumentato anziché diminuire. Seguire la proposta di creare un software che dica come intervenire per evitarli sembra ragionevole.

I dati dell'Uppsala Conlfict Data Program mostrano nettamente come il numero dei conflitti sia aumentato dalla fine della Seconda Guerra mondiale.

Dubbi

Sottolineato che lo scenario evocato da Gleditsch, Gui e Wilson è tutt’altro che in fase di realizzazione, non mancano anche i dubbi sulla sua eventuale efficacia. Lo racconta un approfondimento apparso sul sito Spectrum pubblicato dall’Institute of Electrical and Electronics Engineers (IEEE), un’associazione internazionale di scienziati che vuole promuovere le scienze tecnologiche e uno dei think tank tecnologici più importanti al mondo. I problemi che vengono sottolineati sono due: con quali dati alimentare i modelli e quale grado di autonomia decisionale devono avere i software. Cominciamo da quest’ultimo con una storia dei tempi della Guerra Fredda.

Sul Bulletin of the Atomic Scientists, l’analista Zachary Kallenborn sintetizza così, in modo iperbolico, la preoccupazione che l’intelligenza artificiale senza supervisione umana controlli le armi nucleari: "Se le intelligenze artificiali controllassero le armi nucleari, tutti noi potremmo essere morti". L’aneddoto che esemplifica al meglio la situazione è il cosiddetto “caso Petrov” del 1983. Quando nella notte del 26 settembre i sistemi di allarme indicavano che gli Stati Uniti avevano lanciato una serie di missili nucleari contro l’Unione Sovietica, il tenente colonnello sovietico Stanislav Petrov decise di non allertare il Cremlino, giudicandolo un falso positivo. Se fosse stata un’intelligenza artificiale a supervisionare in modo automatico la situazione, secondo il protocollo sarebbe dovuto partire un contrattacco. Ma il “fattore umano” evitò una guerra nucleare mondiale.

Oltre a delimitare l’automatismo decisionale dell’IA, la seconda preoccupazione è la possibile introduzione di bias (letteralmente “pregiudizi”) attraverso i dati che questi sistemi utilizzano per imparare a prevedere l’esito di un conflitto. Secondo l’analisi di Natasha Bajema su Spectrum, questo è più che mai vero nelle situazioni reali sotto stress: “mettere insieme un set di dati veramente imparziale progettato per prevedere esiti specifici rimane una sfida importante, soprattutto per le situazioni di vita e di morte e in settori in cui la disponibilità di dati è scarsa, come per esempio i conflitti nucleari”. Inserendo nel modello dati che anche inavvertitamente contengono una serie di pregiudizi, potremo fidarci dell’esito della simulazione? “Sfruttare gli strumenti basati sull'intelligenza artificiale per prendere decisioni migliori è una cosa, ma usarli per prevedere le azioni avversarie al fine di prevenirle è una partita completamente diversa”, conclude Bajema.