Poco più di un anno fa, all’interno della comunità scientifica si è aperto un dibattito attorno all’intelligenza artificiale (IA). A scatenarlo la notizia riportata da Nature che ChatGPT è stata indicata come co-autrice di almeno quattro paper scientifici. L’amministratore delegato di un’azienda che ha finanziato una delle quattro ricerche si è addirittura spinto a dire che l’IA avrebbe dato un contributo intellettuale allo studio. Una posizione, questa, che è nettamente rigettata da Daniela Ovadia, docente di etica della ricerca all’Università di Pavia, in un’intervista per il Bo Live di allora.

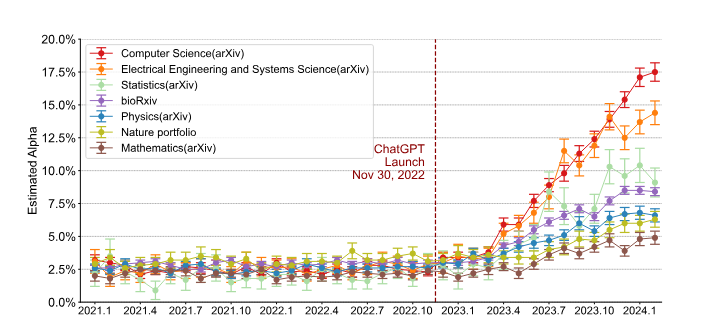

Di quel dibattito però è rimasta un’interessante domanda di ricerca: quanti paper sono scritti con l’aiuto dell’IA? Oggi abbiamo almeno qualche stima che permette di valutare la situazione. Le hanno fatte i ricercatori e le ricercatrici guidate da Weixin Liang, studente di dottorato in Computer Science all’Università di Stanford, in California. Un loro recente articolo apparso su arXiv.org, uno dei principali archivi di preprint, si intitola semplicemente Mapping the Increasing Use of LLMs in Scientific Papers (‘Mappatura dell’uso crescente di LLM negli articoli scientifici’), dove ‘LLM’ sta per Large Language Model, i modelli che sono alla base di bot come ChatGPT. Il team precisa che si tratta di stime, ma ciononostante scrivono che i “risultati rivelano un aumento costante nell’utilizzo di LLM, con la crescita maggiore e più rapida osservata negli articoli di informatica (fino al 17,5%)”. In altri casi, come la matematica, la percentuale è più bassa (6,5%), ma comunque significativa.

Misurare l’uso di LLM

Lo studio di Liang e colleghi ha preso in considerazione oltre 950 mila articoli depositati su arXiv, bioRxiv (due dei più importanti repository di paper in libero accesso) e su una serie di pubblicazioni del gruppo di Nature. Oltre a mostrare una grande presenza di articoli scritti almeno in parte con l’aiuto dell’IA, la ricerca mostra un incremento nel corso del tempo, come si può vedere dal grafico tratto dalla pubblicazione:

Immagine ripresa da Liang et al., Monitoring AI-Modified Content at Scale: A Case Study on the Impact of ChatGPT on AI Conference Peer Reviews

Già prima dell’arrivo di ChatGPT una percentuale che oscillava attorno al 2,5% dei paper aveva visto il contributo dell’IA. Ma con il lancio del bot di OpenAI questa percentuale è aumentata in maniera molto decisa.

Il risultato è in linea con un altro lavoro, sempre guidato da Liang, e pubblicato anch’esso su arXiv.org. In questa ricerca, che aveva più il compito di funzionare da caso di studio per la metodologia di stima, le percentuali di paper scritti con il contributo dell’IA oscillava tra il 6,5% e il 16,9%. Inoltre, il team di ricerca era in grado di notare un aumento dell’uso di aiuti digitali mano a mano che ci si avvicina alla data di scadenza per la consegna. In questo caso, infatti, sono stati utilizzati come banco di prova le relazioni di revisione che scienziati e scienziate scrivono del lavoro di colleghi e colleghe. A differenza di un paper classico, in questo caso c’è una data che il sistema editoriale fornisce come indicazione della consegna, e quindi è possibile utilizzare la distanza dalla scadenza come indicatore.

“ La frazione stimata del testo generato da LLM è più elevata nelle revisioni che segnalano un livello di confidenza inferiore, sono state inviate in prossimità della scadenza e da revisori che hanno meno probabilità di rispondere alle confutazioni

Il risultato è che “la frazione stimata del testo generato da LLM è più elevata nelle revisioni che segnalano un livello di confidenza inferiore, sono state inviate in prossimità della scadenza e da revisori che hanno meno probabilità di rispondere alle confutazioni dell’autore”. In altre parole, se ho poco tempo a disposizione, oppure sono abbastanza sicura che chi riceve la mia relazione non avrà modo di controbattere allora mi affido con più facilità all’IA invece che produrre la relazione in maniera autonoma.

Il problema delle revisioni e della peer-review

Il tema delle revisioni dei lavori altrui, perno fondamentale del sistema di revisione tra pari (peer review) alla base del funzionamento della scienza, è al centro di una certa discussione. Recentemente, su Semafor, sito di informazione americano che si occupa molto del mondo dell’editoria periodica e dell’informazione, è stato pubblicato un articolo intitolato Researchers warned against using AI to peer review academic papers (‘I ricercatori mettono in guardia contro l’uso dell’intelligenza artificiale per la revisione paritaria di documenti accademici’). Nel pezzo si racconta come per alcuni membri della comunità scientifica l’impiego dell’IA per la scrittura automatizzata di revisioni di paper altrui minerebbe alle fondamenta il concetto stesso di peer review.

“ I revisori sono responsabili dell’accuratezza e delle opinioni espresse nelle loro valutazioni e sono proprio loro a contribuire a garantire l’integrità, la riproducibilità e la qualità della documentazione scientifica

Si racconta, inoltre, come la Conference and Workshop on Neural Information Processing Systems, un’importante conferenza scientifica nell’ambito delle neuroscienze, stia pensando di modificare le proprie linee guida per vietare l’uso dell’IA per la revisione dei paper da parte dei propri revisori. Una fonte anonima consultata da Semafor e che lavora nel gruppo Nature ha dichiarato che “i revisori sono responsabili dell’accuratezza e delle opinioni espresse nelle loro valutazioni e sono proprio loro a contribuire a garantire l’integrità, la riproducibilità e la qualità della documentazione scientifica”. Inoltre, secondo la stessa fonte, l’expertise di chi fa revisioni “è insostituibile e, nonostante i rapidi progressi, gli strumenti di intelligenza artificiale generativa possono mancare di conoscenze aggiornate e possono produrre informazioni prive di senso, distorte o false”.

Ma quanta IA è accettabile?

Se non puoi vincerli, fatteli amici. Così recita un vecchio adagio che sembra essere utilizzato da un’altra fazione di questo dibattito molto complesso e articolato. In questo caso, alcune persone pensano che nel momento in cui chiunque utilizzerà l’IA per scrivere parte dei propri paper, c’è una soglia di utilizzo oltre la quale non è più lecito? Posto, come ricordava Ovadia e come ha dichiarato la fonte di Nature a Semafor, che l’IA al momento non può essere indicata come autrice o co-autrice di un paper, quanta parte del paper può essere testo generato da un bot?

Secondo un articolo pubblicato da ai-detector.info, uno dei servizi online che permette di valutare se un testo è scritto da un bot o meno, dipende dall’ambito disciplinare. Per esempio, nel settore delle scienze sociali sarebbe accettabile una percentuale tra il 10 e il 20%. Ma nel caso della medicina, questa può salire tranquillamente fino al 25-35%. C’è una vera e propria tabella che l’autore dichiara essere basata sull’opinione di esperti dei diversi settori e sulle norme etiche che gli editori hanno finora messo in campo.

E qui sembra essere uno dei nodi più importanti del dibattito che, tra l’altro, riporta direttamente agli aspetti etici toccati da Ovadia. Un aiuto da parte di strumenti così potenti come i bot basati su LLM è troppo prezioso per non diventare parte integrante del lavoro di ricerca, ma il loro sviluppo è talmente rapido che sembra insostenibile per i tempi di reazione degli editori e delle istituzioni di ricerca. Lo si è visto con la ricerca di Liang e colleghi: nel giro di poco più di un anno la percentuale di paper che hanno sfruttato l’IA è più che raddoppiata. In alcuni casi si è moltiplicata per sei volte. Nello stesso tempo non si sono ancora individuati standard condivisi per stabilire quanta IA sia lecita.