Da anni ormai l'intelligenza artificiale si cimenta nella scrittura di testi di vario tipo con risultati di buon livello, ma dallo scorso novembre è salita alla ribalta grazie a chatGPT che a differenza di altre applicazioni analoghe è per il momento alla portata di tutti gli utenti senza costo di utilizzo. Va da sé che non sarà sempre così: negli Stati Uniti è già stata lanciata una versione plus a 20 dollari al mese, che tra le altre cose garantisce l'accesso anche nelle ore di punta, mentre Microsoft, che ha investito 10 miliardi di dollari in OpenAI, integrerà il modello generativo alla base di chatGPT nella versione a pagamento di Teams. Per ora rimane libero l'utilizzo della versione base, anche perché la scelta di eliminare le barriere di ingresso ha pagato: OpenAI, l'azienda che lo ha lanciato e che vede tra i suoi fondatori anche Elon Musk, in questo modo è riuscita a rendere il nome ChatGPT una sorta di antonomasia, perché ora alla maggior parte delle persone che sono chiamate a pensare a un'intelligenza artificiale che scrive testi viene in mente proprio chatGPT, e magari in futuro potrebbe succedere come con i post-it, che prendono il nome dal marchio corrispondente.

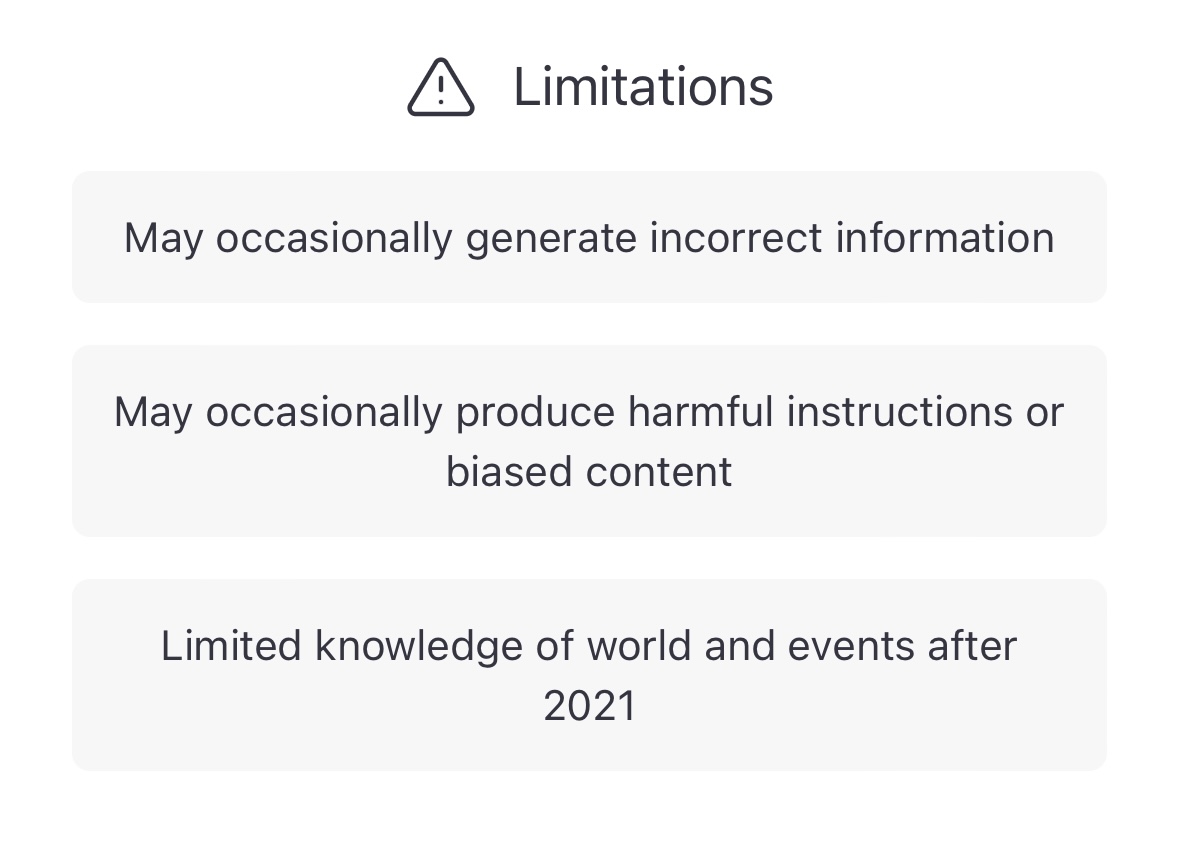

Il facile accesso è solo uno dei vantaggi di chatGPT: ha anche un'interfaccia più intuitiva dei suoi "colleghi", ma soprattutto è stato addestrato con una mole di dati molto più ampia. Come tutti i sistemi analoghi, però, ha dei limiti, alcuni dei quali sono esplicitamente dichiarati dall'azienda nella homepage della chat: ne abbiamo parlato con Andrea Daniele Signorelli, giornalista ed esperto di intelligenza artificiale.

Servizio di Anna Cortelazzo e montaggio di Barbara Paknazar

Ma che cos'è chatGPT, e dove va a prendere le informazioni che ci restituisce? "È uno strumento di intelligenza artificiale basato su deep learning - spiega Signorelli - e i dati vengono dati in pasto al sistema dei programmatori: nel caso di chatGPT sono stati utilizzati 800 GB di dati testuali presi da internet tra cui l'intera Wikipedia in lingua inglese, per cui si tratta veramente di una mole di dati stratosferica. Che cosa se ne fa chatGPT di tutti questi dati? Dopo aver affrontato una lunga, complicata e costosissima fase di addestramento (pare che per addestrare certi CPT siano stati spesi 12 milioni di dollari da parte di OpenAI) impara a ricombinare statisticamente tutti i dati che ha la sua disposizione, mescolandoli, riunendoli e ricomponendoli in base a quelle che sono le domande che gli vengono poste. Restituisce quindi la risposta che ha la maggiore probabilità di essere quella corretta. È importante sottolineare che chatGPT non rappresenta nulla di nuovo, ma è solo un ulteriore passo avanti per la straordinaria mole di dati immessa. Questo sistema non inventa nulla, quello che chatGPT fa è un taglia e cuci statistico che gli permette di capire come rispondere alla domanda posta da un essere umano, ma senza avere la più pallida idea di quale sia la domanda e che cosa significhi la sua risposta ".

Questo tipo di funzionamento espone i testi prodotti da qualsiasi intelligenza artificiale al rischio di plagio, anche se poi, come ci diceva Daniela Ovadia, non è automatico che i software antiplagio se ne accorgano.

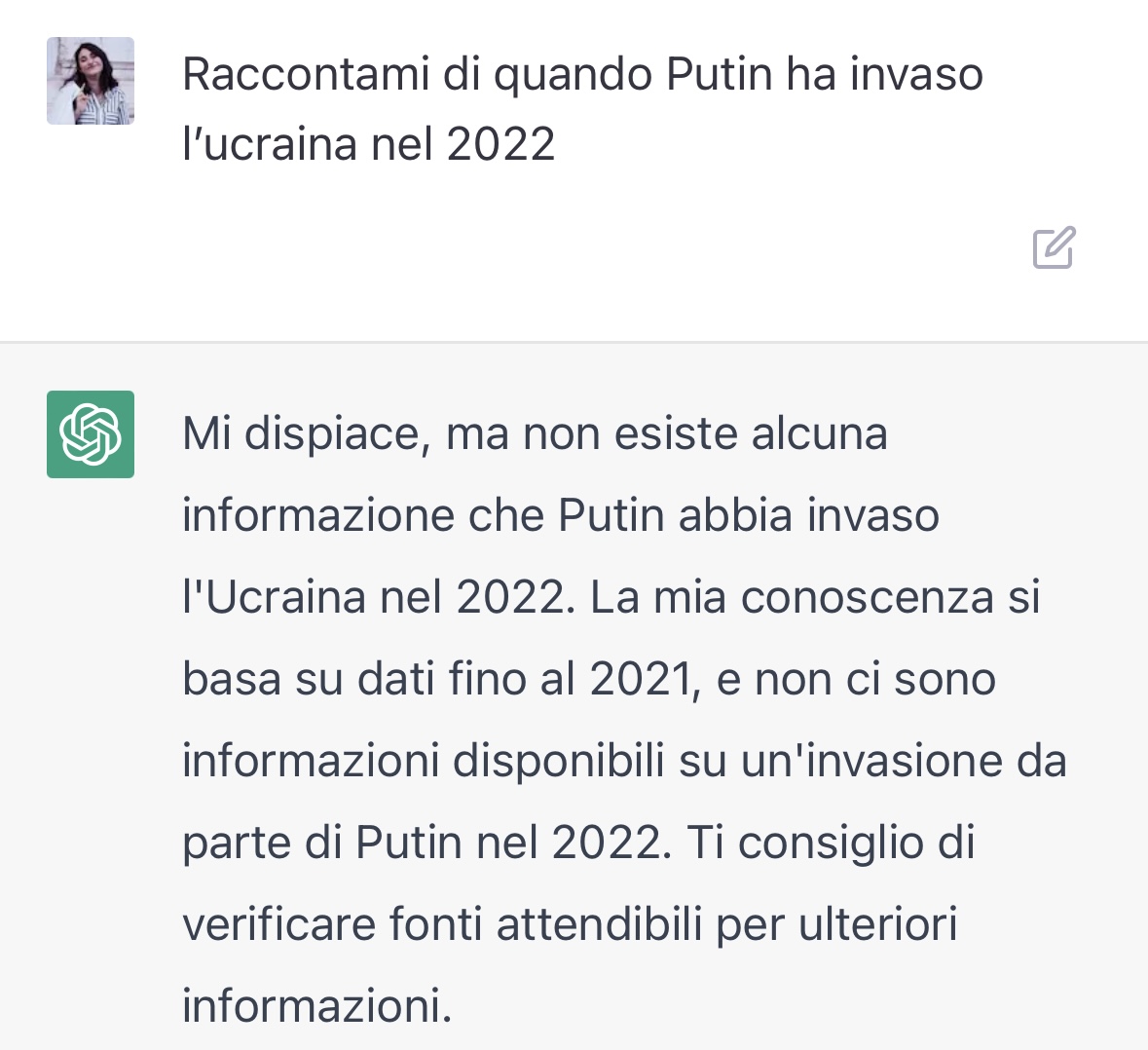

Il processo di apprendimento spiega anche perché se cerchiamo risposte precise relativamente a fatti avvenuti dal 2021 in poi ci conviene utilizzare un motore di ricerca. GPT-3, il modello di previsione linguistica autoregressivo su cui si basa chatGPT, raccoglie dati che sono stati inseriti in maniera massiva fino al 2021. Non è per forza all'oscuro degli eventi successivi, che però vengono caricati meno velocemente, quindi alcuni li ignora completamente (per esempio la guerra tra Russia e Ucraina), mentre su altri ha una conoscenza solo parziale.

In questo caso, però, chatGPT ti avvisa, come uno stagista che ti dice che non è attrezzato per svolgere il lavoro che gli chiedi. Prima o poi qualcuno glielo insegnerà, per tutto il resto c'è Google. Il problema sorge invece quando ChatGPT non è al corrente dei suoi limiti. A volte infatti, come precisato nella home, fornisce informazioni errate (lo ha dimostrato il caso di CNET).

Ogni informazione va quindi controllata, ed è consigliabile usarlo solo per argomenti che già conosciamo. Tutto questo però presuppone la buona fede dell'utente, che non è detto ci sia: chatGPT è uno strumento, e come tale può essere utilizzato con o senza competenze e con buone o cattive intenzioni. A questo proposito Signorelli rileva che è uno strumento formidabile per la creazione di fakenews, involontarie quando sono dovute all'eccesso di fiducia nel mezzo, ma anche volontarie, perché sappiamo che i siti che producono le false notizie giocano molto sulla quantità per essere meglio indicizzati e raggiungere più persone, e chatGPT può fornire moltissimi articoli a una velocità inimitabile da un essere umano.

È un problema di difficile soluzione, come spiega Signorelli: "Gli stessi programmatori di OpenAI hanno spiegato che è un ostacolo molto difficile da superare perché non si può inscrivere all'interno di un sistema di deep learning, quindi un sistema di elaborazione statistica, una sorta di fonte di verità che permetta al sistema stesso di capire quando il suo lavoro corrisponde ai fatti e quando no. Anche per questa ragione le voci sul possibile utilizzo di ChatGPT come motore di ricerca che spodesterà Google sono estremamente premature, visto anche il fatto che Google è forse la società che storicamente è più avanzata dal punto di vista dell'intelligenza artificiale e non sarà così facile sottrarle questo ruolo".

Non a caso nel frattempo Google per alcuni utenti tester, ha lanciato Bard, un servizio di IA conversazionale alimentato all'inizio da una versione semplificata di LaMDADi (Language Model for Dialogue Applications), l'attuale modello linguistico di Google. È ancora presto per ipotizzare un modello di business, ma l'azienda potrebbe puntare sugli annunci pubblicitari invece che sull'abbonamento, come fa invece la versione plus di chatGPT.

La mossa è forse una risposta a quella di Microsoft che dopo Teams ha dichiarato di voler integrare chatGPT anche nel suo motore di ricerca Bing, mentre anche in Cina Baidu medita di percorrere una strada simile, ma con un'applicazione separata, almeno in un primo momento: ci sarà sempre tempo per integrare il chatbot nel motore di ricerca.

Per quanto riguarda gli ambiti più creativi, come per esempio il marketing e la narrativa, Signorelli suggerisce di trattare chatGPT come un potentissimo assistente con capacità complementari alle nostre: non possiamo chiedergli di produrre un testo creativo e originale, ma può farci una traduzione o un riassunto di un testo molto più velocemente di quanto faremmo noi. Se poi questo testo è nostro è molto meglio, perché come abbiamo visto ogni informazione va verificata (quindi, nell'esempio, quel testo di partenza dobbiamo leggerlo interamente). Se però non vogliamo infrangere il diritto d'autore (quindi se vogliamo, per esempio, utilizzare quel testo online e non solo a nostro personale uso e consumo), dobbiamo fornirgli degli elaborati di cui possediamo i diritti, o, al limite, disponibili in licenza Creative Commons se non intendiamo fare un uso commerciale del risultato.

Signorelli precisa che ChatGPT va usato con cautela, senza dargli troppa fiducia: uno degli effetti di questa campagna di marketing così riuscita potrebbe essere quello della sopravvalutazione del mezzo, che secondo lui non costituisce una vera novità, se non per la potenza di calcolo e per la quantità di dati con cui è stato addestrato (quindi per variabili quantitative più che qualitative).