Odio online. Lo studio su dinamiche e relazione con la disinformazione

Un paper sull'odio online, appena pubblicato su Nature Scientific Reports, analizza le dinamiche comportamentali e la relazione degli utenti con la disinformazione. I dibattiti online sono spesso caratterizzati da un'estrema polarizzazione e da accese discussioni. La presenza di incitamento all'odio in rete sta diventando sempre più problematica, e rende necessario lo sviluppo di adeguate contromisure di prevenzione e contenimento. Il paper analizza l'incitamento all'odio su un corpus di oltre un milione di commenti sui video di YouTube, attraverso un modello di apprendimento automatico messo a punto su un ampio set di dati annotati a mano.

Li chiamiamo "leoni da tastiera", ma non ci sono prove della presenza di odiatori puri (seriali, per capirci), intesi come utenti attivi che pubblicano esclusivamente commenti di odio. Questo dettaglio rende meno grave la questione? Non proprio, perché ci dice che gli haters non appartengono a categorie identificabili. In un panorama segnato profondamente dagli effetti della pandemia, anche dal punto di vista psicologico, emergono ora informazioni dall'universo online relative a una tossicità complessiva, che sembra aumentare con la lunghezza della discussione, misurata sia in termini di numero di commenti che di tempo. I risultati mostrano che, coerentemente con la legge di Godwin, i dibattiti online tendono infatti a degenerare verso scambi di opinioni sempre più tossici. Non sono state raccolte informazioni relative ad argomenti specifici capaci di scatenare reazioni di odio online né vere proprie "categorie" di haters, ma si è notata la tendenza degli utenti sbilanciati verso una della categorie di canali video (discutibile, affidabile) a usare un linguaggio inappropriato, offensivo o violento all'interno della comunità "avversaria". Inoltre, dato interessante, gli utenti fedeli a fonti affidabili usano in media un linguaggio più tossico della loro controparte. Fabiana Zollo, coautrice dello studio, ha risposto alle domande de Il Bo Live.

Quando è iniziato il lavoro di ricerca? Quali gli obiettivi?

"La ricerca è stata svolta nell'ambito del progetto europeo IMSyPP - Innovative Monitoring Systems and Prevention Policies of Online Hate Speech, partito a marzo 2020 e della durata di 2 anni. Il progetto si pone come obiettivo principale l'analisi dei meccanismi che governano la formazione e diffusione di hate speech online e la formulazione di proposte data-driven per contrastarne la diffusione".

Chi ha coordinato lo studio?

"Il primo autore è Matteo Cinelli, assegnista di ricerca a Ca' Foscari. Lo studio è frutto della collaborazione del team di Ca' Foscari con lo Jozef Stefan Institute di Ljubljana, coordinatore del progetto IMSyPP".

Chi/che cosa prendete in esame?

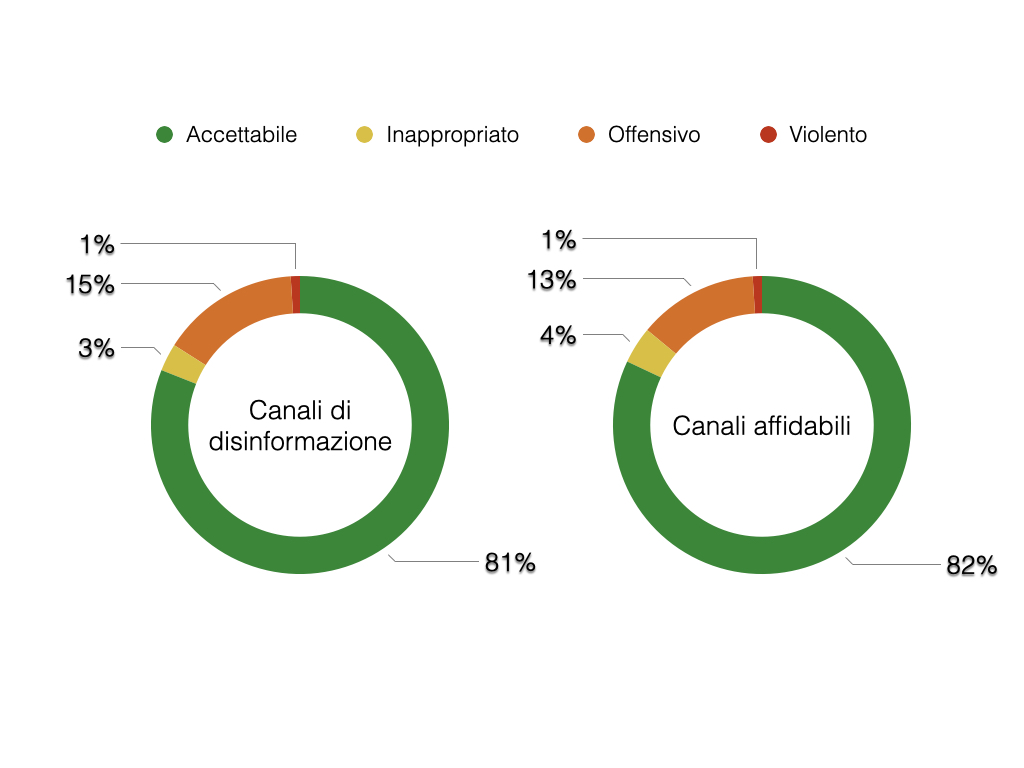

"Abbiamo prima sviluppato un modello di machine learning per hate speech detection e poi lo abbiamo applicato a un corpus di più di 1 milione di commenti a video della piattaforma YouTube. In questo modo, siamo in grado di assegnare 'un'etichetta' a ogni commento e classificarlo come appropriato, inappropriato, offensivo o violento, a seconda della tipologia di linguaggio utilizzata".

“ La quasi totale assenza di odiatori puri suggerisce che il fenomeno dell'odio online non sia relegato a una determinata categoria di utenti

Grafico: Fabiana Zollo

“ Solo il 32% dei commenti classificati come violenti sono stati rimossi dalla piattaforma o dall'autore a un anno dalla pubblicazione

Leggo: non esistono odiatori puri. Perché allora non mi sembra una buona notizia? Gli haters possono "spuntare a sorpresa", essere potenzialmente ovunque: questo rende più difficile individuarli e arginare il fenomeno?

"La quasi totale assenza di odiatori puri suggerisce che il fenomeno dell'odio online non sia relegato a una determinata categoria di utenti. Piuttosto, sembra che l'utilizzo di un linguaggio offensivo e violento da parte di utenti 'regolari' sia scatenato occasionalmente da fattori esterni. Lo studio di questi fattori è sicuramente decisivo per individuare le strategie più efficaci per arginare il fenomeno".

Quale il rapporto degli utenti con le fonti? In base a queste, possiamo descrivere delle categorie distinte di "odiatori"?

"Non possiamo definire delle vere categorie di odiatori. I nostri risultati sembrano invece indicare che gli utenti tendono a utilizzare un linguaggio inappropriato, offensivo o violento nelle comunità ''avversarie', in altre echo chamber. Cosa interessante, gli utenti che si informano principalmente da fonti affidabili utilizzano in media un linguaggio più tossico della loro controparte".

Cosa intendiamo esattamente per linguaggio tossico?

"Nel nostro studio distinguiamo tra diverse categorie di linguaggio, i cui livelli di tossicità sono via via crescenti. Un commento inappropriato contiene termini osceni o volgari, ma il testo non è diretto a nessun gruppo o persona in particolare. Un commento offensivo contiene invece una generalizzazione offensiva, disprezzo, deumanizzazione, o considerazioni offensive indirette. In un commento violento, l'autore minaccia, asseconda, desidera o invita alla violenza contro un certo target, o crimini di guerra e contro l'umanità".

Cosa si può fare per prevenire, dove possibile, o arginare l'odio online?

"Il nostro studio offre una prima importante panoramica del fenomeno su YouTube, che in Italia coinvolge 24 milioni di utenti (1/3 della popolazione). Questo tipo di ricerche è quindi cruciale per cercare di capire come contrastare il fenomeno. I nostri risultati, ad esempio, mostrano che solo il 32% dei commenti classificati come violenti sono stati rimossi dalla piattaforma o dall'autore a un anno dalla pubblicazione".