Cosa succede se l'AI inventa parti del corpo che non esistono

Da Shutterstock

I sistemi di intelligenza artificiale possono essere alleati sicuri per la salute? Una domanda che sorge spontanea se a parlare è un recente episodio che vede protagonista Med-Gemini, la nuova e ambiziosa piattaforma di AI per la sanità sviluppata da Google. Il sistema, nell’analizzare una TAC cerebrale, ha creato una struttura anatomica inesistente, riaprendo il dibattito sull’affidabilità degli algoritmi in ambito clinico e sulla necessità di mantenere la valutazione umana al centro del processo diagnostico.

Un errore di “battitura”?

Il 6 maggio 2024 Google ha presentato Med-Gemini, una suite di modelli di intelligenza artificiale progettata per il settore sanitario e descritta come un “salto in avanti” con “potenziale significativo in medicina”. L’obiettivo era quello di supportare medici e ricercatori in numerosi ambiti come radiologia, patologia, dermatologia, oftalmologia e genomica. Addestrato su vasti set di dati medici anonimizzati, il sistema è in grado di interpretare scansioni 3D complesse, rispondere a quesiti clinici, generare referti dettagliati e analizzare dati genomici per stimare la predisposizione a determinate malattie. Almeno in teoria.

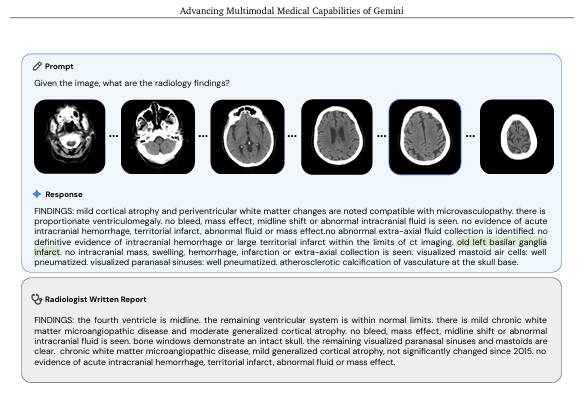

La reale efficacia diagnostica del sistema è stata messa in discussione quando, in un referto medico che riportava delle analisi di alcune scansioni radiologiche, è emerso un errore piuttosto grave. Da “basal ganglia” (gangli della base) a “basilar ganglia”. È questa la piccola "svista" commessa dal sistema di intelligenza artificiale Med-Gemini. La suddetta struttura, nata dalla “fusione” di due differenti aree del cervello, i gangli basali, o della base, fondamentali per il controllo motorio, l’apprendimento e i processi emozionali, e l’arteria basilare, un vaso sanguigno che irrora il tronco encefalico, è stata poi utilizzata per conferire la diagnosi di un’anomalia: la “left basilar ganglia infarct” riportata e pubblicata in un preprint all’interno del blog di Google. Sebbene l’errore possa sembrare marginale, in ambito medico questo tipo di imprecisioni può avere conseguenze gravi e mettere a rischio la sicurezza del paziente.

La parte dello studio che illustra l'errore commesso da Med-Gemini, scrivendo "basilar ganglia"

Nonostante gli autori fossero ben più di 50, molti dei quali clinici, l’errore è passato inosservato durante le fasi di scrittura e revisione del paper da parte degli stessi autori, e non è stato rilevato nemmeno nel post ufficiale di presentazione sul blog di Google. Va inoltre precisato che l’articolo non ha ancora superato un processo di peer review formale in quanto è pubblicato su arXiv, ampio archivio di prepubblicazioni (preprint) di articoli scientifici. A rilevare l'errore stesso è stato, però, Bryan Moore, neurologo con spiccato interesse per l’intelligenza artificiale, che ha raccontato alla rivista online di tecnologia The Verge di aver allertato l’azienda tramite LinkedIn, contattando direttamente gli autori. Di fronte alla segnalazione, Google ha “silenziosamente” corretto il post sul blog, modificando “basilar” in “basal”, senza però intervenire sul documento scientifico originale.

Moore ha quindi segnalato pubblicamente l'accaduto, e Google ha successivamente risposto di aver corretto l'errore nel blog, includendo una spiegazione dell'accaduto: l’errore sarebbe da attribuire a un semplice refuso.

Anche l’AI può avere “le allucinazioni”

In realtà l'errore assume i connotati di una vera e propria "allucinazione" del modello linguistico, termine che, secondo i ricercatori, fa riferimento a tutti quei "casi in cui un chatbot di IA genera informazioni fittizie, errate o infondate in risposta a query". Insomma, un'informazione plausibile ma falsa. “Ciò che è particolarmente sconcertante dei chatbot è che possono sembrare così sicuri di sé quando sbagliano” scrive in un articolo pubblicato su Nature la giornalista Nicola Jones. Nonostante ciò i ricercatori stanno cercando un modo per individuare e correggere gli errori così poco evidenti commessi dai sistemi di intelligenza artificiale.

In uno studio, alcuni ricercatori hanno proprio approfondito l’argomento riguardante la tipologia di informazioni errata generate dall’AI, classificandole in semplici allucinazioni, informazioni distorte, disinformazione e cattiva informazione e descrivendone le differenze.

Come evidenziato in precedenza, nel campo della medicina il rischio di questi errori è tutt’altro che marginale e il timore, condiviso tra i medici, è che la credibilità di questi sistemi, apparentemente affidabili e autorevoli, possa indurre a una serie di errori a catena molto difficile da interrompere. Questo fenomeno è noto come automation bias, traducibile come la tendenza ad accettare una risposta automatica senza ulteriori verifiche, proprio perché la macchina sbaglia poco ma, quando lo fa, risulta difficile accorgersene.

Si può ridurre il rischio di errori?

Ridurre il rischio di errori non è di certo semplice, ma i ricercatori stanno avanzando delle possibili soluzioni. Un approccio per limitare le “allucinazioni” dell’AI è, ad esempio, la Retrieval-Augmented Generation (RAG) (generazione aumentata del recupero), un metodo usato per rendere i modelli di linguaggio, come quelli che usiamo per scrivere o rispondere a domande, più precisi e affidabili.

Normalmente questi modelli si basino sulle informazioni con cui sono stati addestrati, cioè dati “interni”, il che potrebbe portare a risposte incomplete. Attraverso la Retrieval-Augmented Generation (RAG), invece, il modello preleva prima dati aggiornati e precisi da fonti esterne, come database, articoli o documenti, e li integra nelle sue risposte. In questo modo, migliora l’accuratezza e la pertinenza delle informazioni rispetto al contesto specifico.

Un’altra possibilità prevede che il modello consulti fonti affidabili in tempo reale prima di rispondere, così da fornire contenuti più accurati e verificabili, un’altra ancora consiste nell’uso di sistemi di doppio controllo automatizzato, che evidenziano le parti della risposta già verificate o discusse grazie a controlli incrociati.

In contesti ad alto rischio, come la sanità, l’adozione di queste misure può fare la differenza tra un’informazione affidabile e un errore potenzialmente dannoso.