AI generativa nella musica: le macchine possono comporre?

Disklavier del CSC. Foto: Canazza / Fiordelmondo

L’avvento dell’intelligenza artificiale (Artificial Intelligence, AI) nella nostra quotidianità ha modificato radicalmente gli equilibri di molti ambiti come il lavoro, la società e la cultura umana, andando a trasformare alcune attività reputate prerogative dell’essere umano. Una tra queste, è sicuramente il campo dell’arte.

Co-creatività

Nell’ambito della produzione artistica, il riferimento al creare è da sempre presente e nel tempo si è trasformato nella creatività, ossia l’attitudine al creare. Da quando i modelli di intelligenza artificiale generativa sono diventati parte della quotidianità, il dibattito si è acceso, domandandosi se la creatività possa essere attribuita anche alle reti neurali artificiali e ai loro output. Ponendo così la questione, sembra che l’essere creativo sia una sorta di proprietà magica che di volta in volta viene associata a un ente, ma è più esatto immaginarlo come un fare, un’azione. Per semplicità, possiamo isolare tre verbi inerenti alla sfera della creatività che possono descriverne alcune sfumature. Il primo è, appunto, “creare”, azione che implica un cominciamento dal nulla ed è storicamente attribuita a Dio. Il secondo è “generare” ed è un verbo che rimanda all’immaginario della maternità: si riferisce a un avvenimento che è inserito in una concatenazione di eventi e tipicamente coinvolge un organismo con un metabolismo che appartiene alla sfera della Natura. Infine, il verbo “produrre”, che solitamente si riferisce alla capacità dell’essere umano di dare origine agli oggetti attraverso l’esercizio della tecnica.

Il concetto di creatività, come osserviamo dai diversi modi in cui viene messo in atto, è frastagliato, è cambiato nel corso della storia e non ha una definizione unitaria. Senza ripercorrere tutte le tappe dei cambiamenti che hanno segnato la concezione della creatività, è interessante notare come di volta in volta, oltre alle sfumature del significato, sia cambiata anche l’attribuzione all’ente che la possedeva o la esercitava. Pensiamo all’antichità: il concetto di creazione non esisteva e l’arte era vista solo come un’esecuzione conforme alle regole. Nel Medioevo emerge la creazione dal nulla – ex nihilo –, ma diventa un attributo esclusivo di Dio. Con la modernità, invece, la creazione dal nulla si trasforma nel produrre qualcosa di nuovo e l’attribuzione della creatività passa da Dio all’essere umano e in particolar modo all’artista. La diffusione dell’attribuzione della creatività procede fino a quando, a partire dal Novecento, compare l’idea che anche persone attive in altri campi della produzione umana oltre a quello dell’arte, per esempio nella scienza, possano essere creative. La questione che oggi affrontiamo riguarda un’ulteriore estensione dell’attribuzione della creatività, quella che riguarda le macchine.

In generale, la nozione di creatività, nella sua versione contemporanea, include sempre due anime, quella della novità e quella del valore. La novità è intesa come qualcosa di nuovo e originale rispetto alle produzioni precedenti o al contesto a cui si fa riferimento. Il valore, invece, allude a qualcosa di utile e significativo rispetto alla storia personale dell’artista o alla storia dell’umanità. In riferimento all’ambito dell’AI, l’originalità degli output delle reti neurali non è un punto problematico, perché il risultato del processo di generazione non è un semplice assemblaggio o una riproposizione dei dati di allenamento, ma un elemento inedito rispetto a quelli di partenza. Invece, la questione del valore apre a una discussione e si articola differentemente a seconda della prospettiva con cui si osserva il rapporto tra l’output e gli altri attori del processo creativo. La prima controversia riguarda il problema dell’attribuzione, vale a dire se siamo disposti a riconoscere al prodotto artificiale delle proprietà tali da poterlo considerare, per esempio, un’opera d’arte. Il secondo punto interessa il rapporto dell’oggetto con chi lo produce. Prima di tutto, la domanda del “Chi è l’autore?” apre alla possibilità di considerare autore un ente non umano: non si tratta solamente di una questione filosofica, ma anche di una problematica giuridica. Questa domanda ha a che fare anche con l’intenzionalità: posto che non possiamo considerare le reti neurali come enti coscienti e autocoscienti, siamo disposti ad accettare che la creatività possa essere non intenzionale? Infine, la questione dell’autorialità ha a che fare con il vissuto, che nel caso della produzione artistica umana ha un ruolo centrale ed è strettamente connesso all’avere un corpo. I dataset su cui vengono allenate le reti neurali sono estremamente vasti, ma possono essere paragonati a un vissuto limitato e contingentato come quello di un singolo individuo? Infine, l’ultima controversia riguarda il rapporto che l’oggetto ha con gli enti esterni. Questo caso può essere esaminato sotto due punti di vista. Da una parte il rapporto con il pubblico, quindi il modo in cui cambia la ricezione dell'opera nel momento in cui scopriamo che è generata artificialmente, dall'altra parte il rapporto con la storia, quindi il valore che assume un prodotto artistico a confronto con la tradizione culturale precedente.

A seconda di come concepiamo le reti neurali artificiali – restituendo un’immagine dell’AI più vicina o a uno strumento nelle mani dell’essere umano o a un agente attivo che collabora con l’artista – cambia radicalmente la risposta a queste domande. Il dibattito sulla creatività delle reti neurali artificiali non riguarda solamente problemi filosofici di definizione, ma tocca degli aspetti più concreti e urgenti, come la gestione della generazione artificiale in un sistema capitalistico e le sue conseguenze a livello ambientale. Ci dimentichiamo troppo spesso che l’AI ha una componente hardware e tendiamo a considerarla come una sorta di entità fantasmagorica. Tuttavia, i supercomputer che permettono ai sistemi di intelligenza artificiale di funzionare, richiedono ingenti quantità di acqua per i processi di raffreddamento e un notevole consumo di energia. Inoltre, per ottenere le materie prime necessarie per la costruzione dei computer, come il cobalto e il litio, sono stati avviati dei processi di sfruttamento che hanno stravolto i territori adibiti all’estrazione dei materiali. Lo sfruttamento non riguarda esclusivamente le materie prime, ma anche i lavoratori, sia quelli assegnati alla manodopera sul territorio sia a quelli che gestiscono la mole di dati necessaria per allenare le reti neurali. Un caso emblematico è quello dei clickworkers, persone che solitamente vivono nei Paesi in via di sviluppo e che per pochi centesimi l’ora lavorano a cottimo per etichettare i dati di allenamento. Oltre allo sfruttamento del lavoro di per sé, questo tipo di procedimento è discutibile anche per la sua mancanza di neutralità: la fretta nell’etichettare i dati e la stanchezza provocata dalle condizioni di lavoro, induce i clickworkers a commettere errori e a moltiplicare i bias cognitivi a cui tutti siamo soggetti già in condizioni di riposo, reiterando discriminazioni razziali e di genere che a loro volta si ripercuoteranno sulla generazione di dati nuovi. Questo problema è strettamente connesso alla questione dei diritti d’autore: il nostro sistema di stampo capitalista ha reso possibile l’appropriazione del patrimonio culturale collettivo senza un adeguato compenso per gli autori effettivi. Inoltre, i dati di allenamento provengono principalmente da Canada, Cina e Stati Uniti, motivo per cui tutto ciò che viene generato è inserito in un processo di replicazione del pensiero dominante, inclusi i bias. Infine, i sistemi di intelligenza artificiale sono gestiti e amministrati da poche aziende private che ne detengono il monopolio e possono decidere, non controbilanciati da un potere statale a causa di un vuoto giuridico su questi temi, a chi e a che prezzo concederne l’accesso.

Luoghi comuni e misconcezioni sull'AI generativa nella musica

L'AI generativa nella musica è un campo in rapida evoluzione che offre opportunità entusiasmanti ma anche sfide complesse. È importante superare i luoghi comuni e comprendere le reali capacità e limitazioni di questa tecnologia. L'intelligenza artificiale non sta sostituendo la creatività umana, ma sta emergendo come uno strumento potente che può amplificare e ispirare l'espressione musicale umana in modi nuovi ed entusiasmanti. La chiave per il futuro della musica AI sarà trovare un equilibrio tra l'innovazione tecnologica e l'autenticità artistica, sfruttando le potenzialità di una attività co-creativa umano-macchina. Si diceva, l'intelligenza artificiale generativa, in particolare nel campo della musica, è oggetto di numerosi luoghi comuni e misconcezioni che spesso non riflettono le reali capacità e limitazioni di questa tecnologia. Esaminiamo i più diffusi:

L'AI sostituirà completamente i musicisti umani. Questo è probabilmente il timore più comune, ma anche uno dei meno fondati. I compositori si sono già confrontati con la tecnologia in numerose occasioni. La musica è sopravvissuta all’avvento del registratore, poi a quello del campionatore, poi ancora all’avvento della musica liquida. Il vero valore di una composizione non risiede solo nella sua originalità tecnica, ma nel legame emotivo che si crea con il pubblico. Io non mi preoccuperei tanto per gli artisti, naturalmente portati all'innovazione, quanto per il pubblico che potrebbe accontentarsi di imitazioni. L'adozione di uno stile esistente, sia da parte di umani sia di macchine, è perfettamente legittimo. Forse non è tanto la meccanicità dell'AI a preoccupare, quanto la sua inquietante vicinanza alle capacità umane. Piuttosto che sostituire i musicisti, l'AI sta emergendo come uno strumento complementare che può potenziare e ispirare la creatività umana. La musica è profondamente legata all'esperienza umana, alle emozioni e al contesto culturale. Mentre l'AI può generare melodie o progressioni di accordi, manca ancora della comprensione profonda del significato emotivo e culturale che i musicisti umani portano nelle loro composizioni.

L'AI può creare musica originale dal nulla. Sebbene l'AI possa generare sequenze musicali originali, in realtà si basa su dati di training derivati da musica esistente: non crea veramente dal nulla, ma rielabora e ricombina elementi appresi da composizioni umane preesistenti. Questo solleva questioni interessanti sul concetto di originalità in musica, ma è importante riconoscere che l'AI non possiede una intenzione creativa indipendente.

La musica generata dall'AI è priva di emozione. Questo luogo comune sottovaluta la sofisticatezza dei modelli AI moderni. È ovviamente vero che l'AI non "prova" emozioni nel senso umano, ma può essere addestrata a riconoscere e replicare pattern musicali associati a diverse emozioni. Il risultato può essere sorprendentemente evocativo, anche se l'emozione percepita dall'ascoltatore deriva dalla sua interpretazione.

L'AI renderà la produzione musicale troppo facile e omogenea. È vero che l'intelligenza artificiale generativa sta rivoluzionando il panorama creativo, abbattendo le barriere di competenza necessarie per la produzione di contenuti culturali. Questo fenomeno sta portando a un aumento esponenziale del numero di "autori", sollevando però interrogativi sulla qualità dei risultati ottenuti. Il processo di democratizzazione dell'espressione artistica non è nuovo. Già nell'Ottocento, l'invenzione della fotografia permise anche ai non pittori di produrre immagini. Più recentemente, l’utilizzo dei campionatori in musica ha permesso un ulteriore passo in avanti in questa direzione. Il DJing, in cui il nuovo musicista riproduce musica registrata per un pubblico, mixando tracce diverse e riuscendo a creare un flusso continuo è da decenni considerata un'arte. Oggi, l'AI generativa compie un ulteriore passo avanti. Grazie alla scrittura, lo strumento comunicativo più accessibile dopo la parola, chiunque può creare musiche non referenziali. Questa democratizzazione non elimina la necessità di competenza e creatività umana: l’uso efficace dell'AI nella musica richiede ancora una profonda comprensione musicale e abilità artistiche. L’intelligenza artificiale può potenzialmente aumentare la diversità musicale, permettendo agli artisti di esplorare nuove idee e combinazioni sonore che potrebbero non aver considerato altrimenti.

L'AI non può comprendere o replicare stili musicali complessi. Questo era vero per i primi sistemi di AI musicale, ma i modelli più recenti hanno fatto progressi significativi nella comprensione e utilizzo di stili musicali complessi.

La musica generata dall'AI è sempre riconoscibile come artificiale. Importante premettere che le Intelligenze Artificiali sono oggi in grado di superare in buona percentuale il test di Turing nel ragionamento e nella scrittura. Inoltre, non tutta la musica generata dall'AI è uguale. Alcuni output possono essere facilmente identificabili come artificiali, mentre altri possono essere quasi indistinguibili dalle composizioni umane, soprattutto in generi musicali molto strutturati (al contrario delle musiche che dipendono fortemente dall'improvvisazione) o in frammenti musicali brevi (mentre composizioni più lunghe potrebbero rivelare pattern o incongruenze che suggeriscono un'origine artificiale). La qualità dipende da fattori come la sofisticatezza del modello, la qualità dei dati di addestramento e le specifiche impostazioni usate dall’umano. Spesso le musiche basate su AI sono realizzate in collaborazione con compositori umani. In questi casi, il risultato finale è un ibrido di creatività umana e di generazione AI, rendendo molto più difficile la distinzione. Studi recenti hanno dimostrato che in test alla cieca, gli ascoltatori spesso non riescono a distinguere in modo affidabile tra musica generata dall'AI e musica composta da umani. Uno studio rilevante è stato condotto da Jean-Pierre Briot e François Pachet, pubblicato nel loro libro Deep Learning Techniques for Music Generation (2020). Gli autori hanno riportato risultati di vari esperimenti: “In un test di ascolto alla cieca con brani jazz generati da un sistema AI e brani composti da umani, i partecipanti non sono stati in grado di distinguere in modo significativo tra le due categorie”. Poiché non tutti gli studi giungono alle stesse conclusioni, questo suggerisce che la nostra percezione della 'artificialità' potrebbe essere influenzata da pregiudizi e aspettative, che variano in funzione del gruppo etnico di appartenenza, delle esperienze culturali e del grado di istruzione. Certamente ancora oggi l'AI fallisce nel catturare completamente alcuni aspetti della musica umana, come la coerenza narrativa a lungo termine o l'innovazione stilistica radicale. La crescente difficoltà nel distinguere tra musica AI e umana solleva questioni importanti riguardo ai diritti d'autore, all'autenticità artistica e all'attribuzione delle opere. A chi attribuire l’autorità in un processo di co-creazione? Sicuramente all’umano che ha orchestrato il processo. Ma come escludere l’intelligenza artificiale che ha contribuito alla generazione dei contenuti? Forse bisognerebbe lavorare in questo ambito per riuscire a comprendere l’entità ibrida emergente dalla loro interazione. È importante notare che l'obiettivo dell'AI musicale non è necessariamente quello di ingannare o sostituire i compositori umani, ma piuttosto di fornire nuovi strumenti e possibilità creative. La vera sfida per il futuro sarà trovare modi significativi per integrare queste tecnologie nel processo creativo umano, ampliando le possibilità espressive della musica piuttosto che semplicemente imitando ciò che è già stato fatto.

L'AI musicale è limitata a generi semplici o elettronici. Questo luogo comune ignora i progressi significativi fatti nell'AI per la generazione di musica in una vasta gamma di generi, inclusi quelli classici e acustici. Mentre alcuni generi fortemente strutturati possono essere più facili da modellare per l'AI, la tecnologia sta diventando sempre più versatile.

L’AI è come Google. Il luogo comune che equipara l'intelligenza artificiale generativa a un raffinato motore di ricerca è una semplificazione fuorviante che meriterebbe un’analisi approfondita. Molti sottovalutano l’AI ritenendola solo in grado di eseguire un copia e incolla, producendo quindi solo musiche equiparabili a dei collage digitali, create con estratti di musiche altrui. Mentre invece l’intelligenza artificiale viene addestrata a produrle attraverso un processo di apprendimento (tramite diverse tipologie di architetture informatiche, sempre più raffinate). Le AI individuano delle relazioni formali in alcune musiche esistenti al fine di emulare uno stile. Quindi apprendono, imparano a comporre in modo da mantenere le caratteristiche che sono state individuate come chiave dello stile, sulla base dell’addestramento ricevuto, come in realtà fanno anche i compositori umani. Le AI non copiano: la musica viene creata seguendo quanto richiesto dal prompt sulla base delle capacità di realizzazione che sono state apprese, come facciamo noi. E per questo ogni creazione è diversa.

Disklavier Bösendorfer Concert Grand 290 Imperial ENSPIRE PRO, messo a disposizione dalla Yamaha Corporation per le registrazioni in sede (Gerno di Lesmo) avvenute il 6 agosto 2025. A destra, Alessandro Fiordelmondo

Esempi musicali

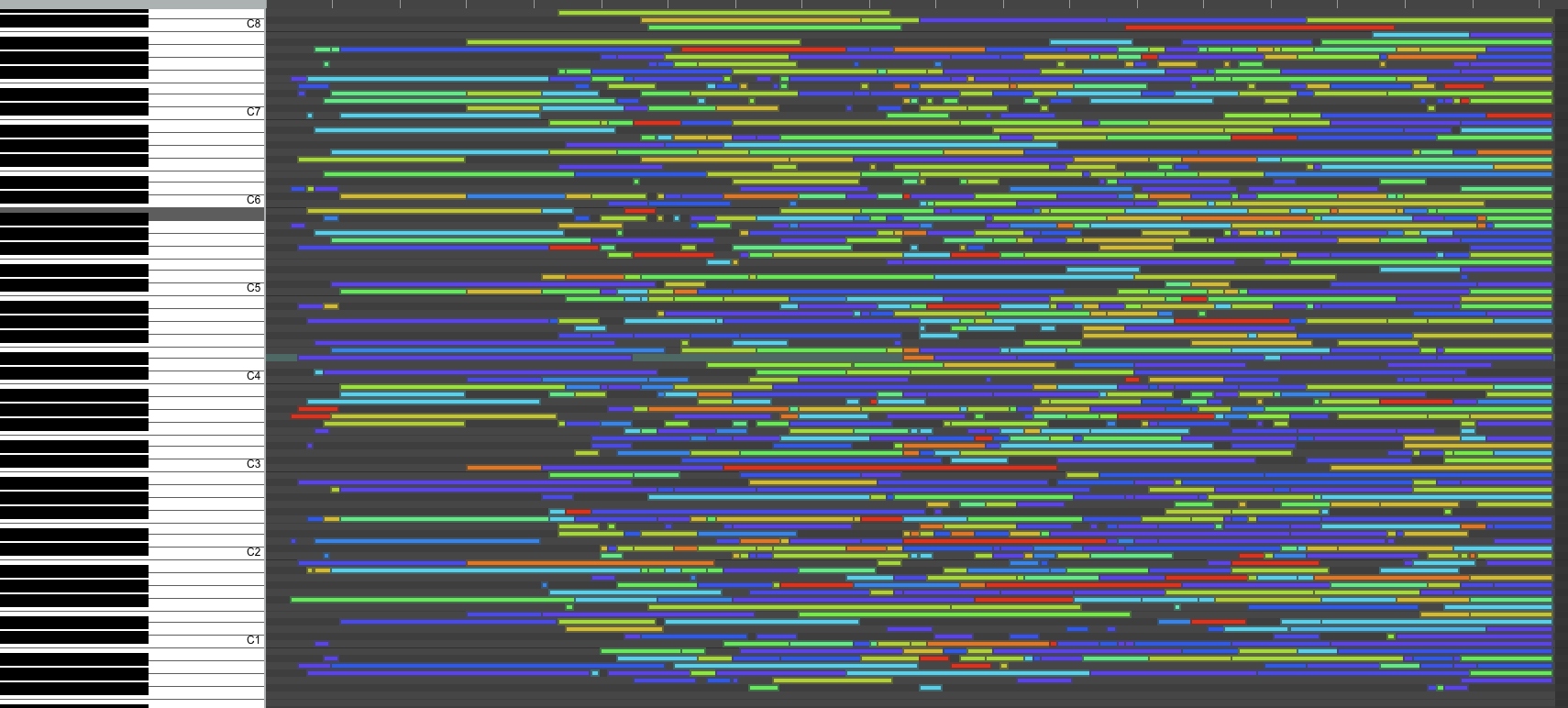

Nel 1913, durante una serata futurista in un teatro di Modena, Luigi Russolo presenta il suo “intonarumori”, un sistema di scatole con leve e manovelle che, se debitamente azionate, riproducono il crepitio, gli scoppi e gli stridori delle macchine. A oltre un secolo di distanza, l’esplorazione della composizione musicale si è trasformata, passando dalle nuove tecnologie di allora, fatte di sbuffi di vapore e ingranaggi, alle nuove tecnologie di oggi, che hanno come protagonisti i dati e le reti neurali artificiali. Cambia il medium, ma le domande rimangono simili: le macchine possono comporre? In che modo cambia la scrittura musicale quando un compositore lavora fianco a fianco di una macchina? Al Centro di Sonologia Computazionale (CSC) del dipartimento di Ingegneria dell’informazione (Università di Padova) è stato condotto uno studio con l’obiettivo di esaminare l’interazione tra il compositore e l’AI generativa. L’esperimento si è svolto in tre passaggi: la composizione del dataset, la generazione artificiale dei brani e, infine, la loro rielaborazione da parte del compositore Ardavan Vossoughi. Lo strumento scelto come destinatario ed esecutore della musica è stato il Disklavier, un pianoforte acustico dotato di attuatori che permettono il controllo da remoto di tasti e pedali e provvisto di sensori che permettono di registrare sia l’audio sia il tocco del musicista sui tasti e trasformare le informazioni in un file MIDI.

File MIDI: standard di comunicazione digitale che permette a strumenti musicali elettronici e computer di interagire tra loro. In sostanza, non contiene audio, ma un insieme di istruzioni che descrivono come suonare uno strumento, specificando note, durata, intensità e altri parametri.

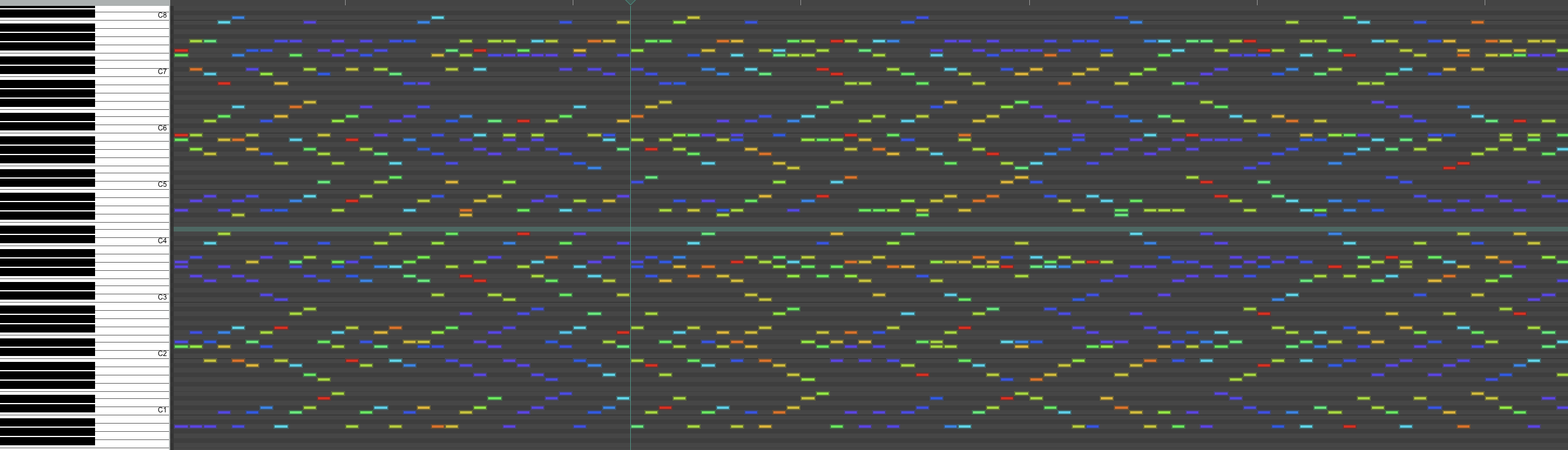

Per la ricerca, la selezione del Disklavier è stata fondamentale per evitare di delegare l’interpretazione dei brani generati artificialmente a un musicista umano. Allo stesso tempo, ha permesso a Vossoughi di esplorare le possibilità compositive di uno strumento che non dipende dai limiti umani e che ha una precisione estrema nell’esecuzione. Inoltre, il compositore ha potuto sperimentare nuove tecniche di utilizzo del Disklavier e ha sentito l’esigenza di scrivere direttamente sul programma Reaper. Il punto centrale di tutta la poetica del Maestro Vossoughi è la ricerca sul suono: per Ardavan, scrivere musica ha sempre un significato interno, che non deve essere influenzato da un’ispirazione proveniente dall’ambiente circostante, al punto da tentare di togliere l’apparato culturale nelle sue composizioni. La procedura del comporre del Maestro Vossoughi può essere descritta, seppur non esaustivamente, in una sequenza di due fasi. La prima consiste nella costruzione di una struttura: a ciascuno strumento vengono assegnate sequenze di note che riempiono lo spartito e si basano su sequenze matematiche, come quella di Fibonacci, o suggerite da un’interazione con chatbot. Durante la seconda fase, Ardavan lavora per sottrazione, svuotando lo spartito e alleggerendo così la struttura piena. Questo passaggio avviene in modo meno sistematico del precedente e permette di mettere in risalto alcuni elementi invece di altri, di assegnare loro il giusto tempo e respiro. È come se si entrasse in una casa buia: le pareti delle stanze ci sono e sono solide, ma non le si vede; poi, pian piano, una luce illumina una di queste pareti, poi un’altra e così via. Il modello di intelligenza artificiale che è stato usato per l’esperimento è Performance RNN di Magenta, una rete neurale che elabora dati sequenziali tenendo conto della loro natura ordinata. La musica viene tradotta in una sequenza di eventi e viene poi rielaborata dal programma. Performance RNN è caratterizzato da una memoria interna, quindi utilizza i dati dei passaggi precedenti della sequenza per influenzare quelli successivi. Il ricercatore del CSC Alessandro Fiordelmondo, dopo aver dato alla rete neurale l’accesso a un dataset predefinito, ha potuto modificare alcuni parametri nella generazione del brano artificiale, quali i numeri di esempi sonori che si vogliono ottenere – quindi i brani effettivi da generare –, il numero di step del processo, ossia la lunghezza del brano – e infine, la temperatura, che regola quanto lo stile compositivo della generazione sia aderente a quello dei brani nel dataset.

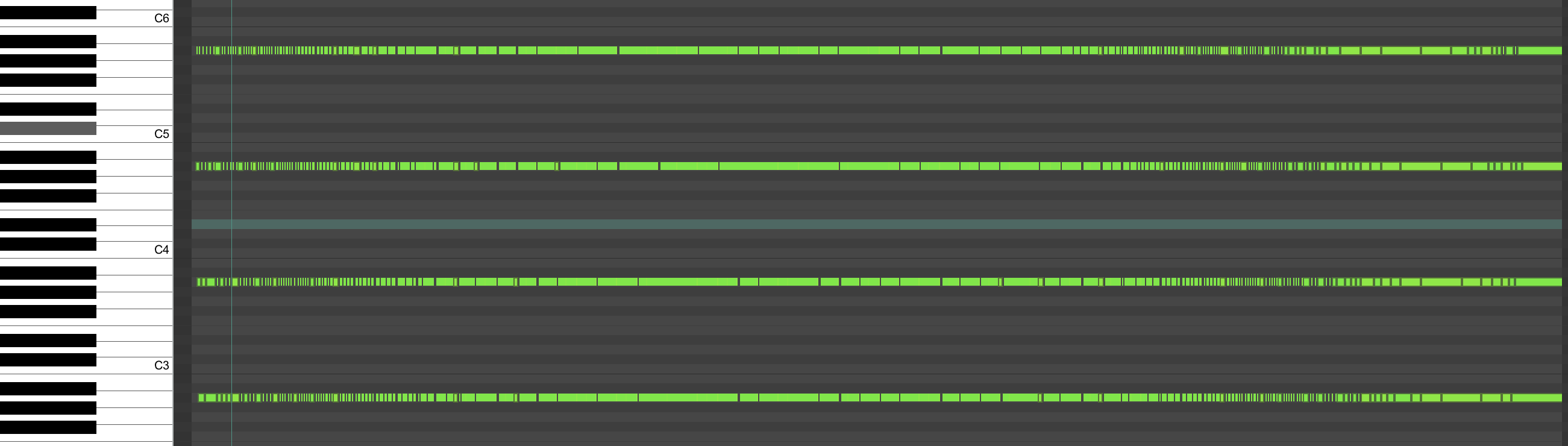

Per la composizione del dataset, il Maestro Vossoughi ha scritto dieci studi per Disklavier. La scelta è ricaduta su degli studi invece che su composizioni vere e proprie per poter esplorare meglio lo strumento e studiare i suoi limiti. Inoltre, gli ha dato la possibilità di sperimentare nuove tecniche. Per esempio, alcuni studi sono incentrati sulla dinamica, che nel Disklavier è regolata con precisione indicando un’intensità da 0 a 127; altri studi esaminano la quantità di note che è possibile far eseguire in contemporanea allo strumento e la loro distanza non contingentata dall’apertura fisica della mano umana; altri studi ancora analizzano gli intervalli impossibili, i ritmi complessi e i passaggi veloci; altri ancora si concentrano sulla differenza tra l’abbassare il pedale e il tener premuti i tasti; infine, altri studi sono sugli armonici. Per esempio, lo studio 7 si concentra sulla grande quantità di note che il Disklavier può suonare in contemporanea. Ciascuna delle note, 4800, ha una propria dinamica e sono gestite su dieci linee diverse di frasi, ognuna basata su una successione matematica diversa.

Lo studio 3, invece, è sugli accordi e sviluppa la scoperta che ciascuna nota che compone un accordo sul Disklavier può non avere la stessa dinamica. Non è uno studio armonico, perché la risultante dell’accordo è stabilita da una serie matematica, la quale lavora su scale aperte. Inoltre, ha la particolarità che l’apertura della mano necessaria a eseguire questi accordi non è fattibile da mano umana, sia come grandezza dell’apertura, sia perché ogni nota ha una dinamica differente e precisa.

Infine, lo studio 5 è dedicato al ritmo: lavorando con una singola nota, il LA, vengono ricercati dei ritmi impossibili. Si alternano accelerandi e rallentandi, quindi riempimenti e svuotamenti, con la massima divisione possibile del ritmo. Facendo le prove con il Disklavier, abbiamo scoperto che, a volume massimo e a tempo di 120 battiti al minuto, la ripetizione di un tasto maggiore di trentaduesimi non permette al tasto di ricevere il segnale. Probabilmente è proprio un limite fisico dello strumento, perché manca il tempo materiale affinché il tasto ribattuto scenda e risalga.

Una volta che tutti gli studi sono stati raccolti per comporre il dataset, tramite Performance RNN sono stati generati un centinaio di pezzi, ciascuno della durata di venti secondi. Alcuni di questi ripropongono elementi degli studi in modo identico, altri con cambiamenti o con fusioni di fattori diversi. Dopo una scrematura iniziale, ne sono stati sottoposti venti al Maestro Vossoughi, che a sua volta ne ha selezionato uno solo per rielaborarlo.

Il lavoro del compositore è stato prima di tutto quello di semplificare il brano eliminando gli elementi superflui. In seguito, il pezzo è stato sdoppiato e trasformato come se fossero due pianoforti a suonare in contemporanea. Gli interventi si sono svolti su due livelli diversi: ad un primo livello le frasi musicali, una di seguito all’altra, vengono eseguite in contemporanea dai due pianoforti (nero e arancione), ma con durate diverse, generando un effetto sfalsato dell’esecuzione; ad un secondo livello, invece, ciascuna delle frasi musicali in sequenza è stata svuotata e riempita di volta in volta con frammento aggiuntivo, ma in senso alterno per i due pianoforti.

L’esperimento condotto ha mostrato come l’incontro tra intelligenza artificiale e composizione musicale non rappresenti una semplice delega creativa alla macchina, ma piuttosto l’apertura di un nuovo spazio di collaborazione e interrogazione estetica. Lungi dal sostituire l’autore umano, l’AI diventa uno strumento di stimolo, di confronto e talvolta di rottura, capace di far emergere possibilità compositive altrimenti inesplorate. Il lavoro di Ardavan Vossoughi, in dialogo con le reti neurali e con uno strumento come il Disklavier, ci invita a ripensare il concetto stesso di scrivere musica: non più come atto esclusivo della volontà umana, ma come processo condiviso. A più di un secolo dall’intonarumori di Russolo, la domanda non è più se le macchine possano fare musica, ma che tipo di musica possiamo costruire insieme a loro. E cosa questo dirà, in fondo, di noi.

I musicisti compositori che hanno collaborato alla realizzazione di questo articolo:

Alessandro Fiordelmondo è un esecutore di musica elettronica e dottore di ricerca nel campo della Time-Based Media Art e della computer music. Ha studiato musica elettronica al Conservatorio di Padova con Alvise Vidolin e Nicola Bernardini. Dal 2019 è assistente ricercatore al Centro di Sonologia Computazionale (CSC) dell'Università di Padova e collabora con lo spin-off Audio Innova.

Ardavan Vossoughi, compositore nato a Teheran nel 1986, ha studiato composizione al Conservatorio "Cesare Pollini" di Padova, all’Accademia Nazionale di Santa Cecilia e all’Accademia Musicale Chigiana con Salvatore Sciarrino. Le sue opere sono state eseguite in Italia, Paesi Bassi, Germania, Francia, Regno Unito, Spagna, Stati Uniti e Iran. Vincitore di premi internazionali, ha collaborato con importanti istituzioni e festival, tra cui la Fondation Biermans Laporte e il Cristofori Festival.

PER APPROFONDIRE

Excavating AI: The Politics of Training Sets for Machine Learning di Crawford K., Paglen T. (2019)

We did the math on AI’s energy footprint. Here’s the story you haven’t heard.The emissions from individual AI text, image, and video queries seem small—until you add up what the industry isn’t tracking and consider where it’s heading next di O’ Donnell J., Crownhart C., in MIT Technology Review (May 20, 2025)

Devi cambiare la tua vita di Peter Sloterdijk (Raffaello Cortina, 2010)

Storia di sei idee: l'arte, il bello, la forma, la creatività, l'imitazione, l'esperienza estetica di Wladislaw Tatarkiewicz (Aesthetica, 1993)

Deep Learning Techniques for Music Generation di Jean-Pierre Briot, Gaëtan Hadjeres, François Pachet (Springer, Cham 2020)