Claude Shannon, il padre della teoria dell'informazione

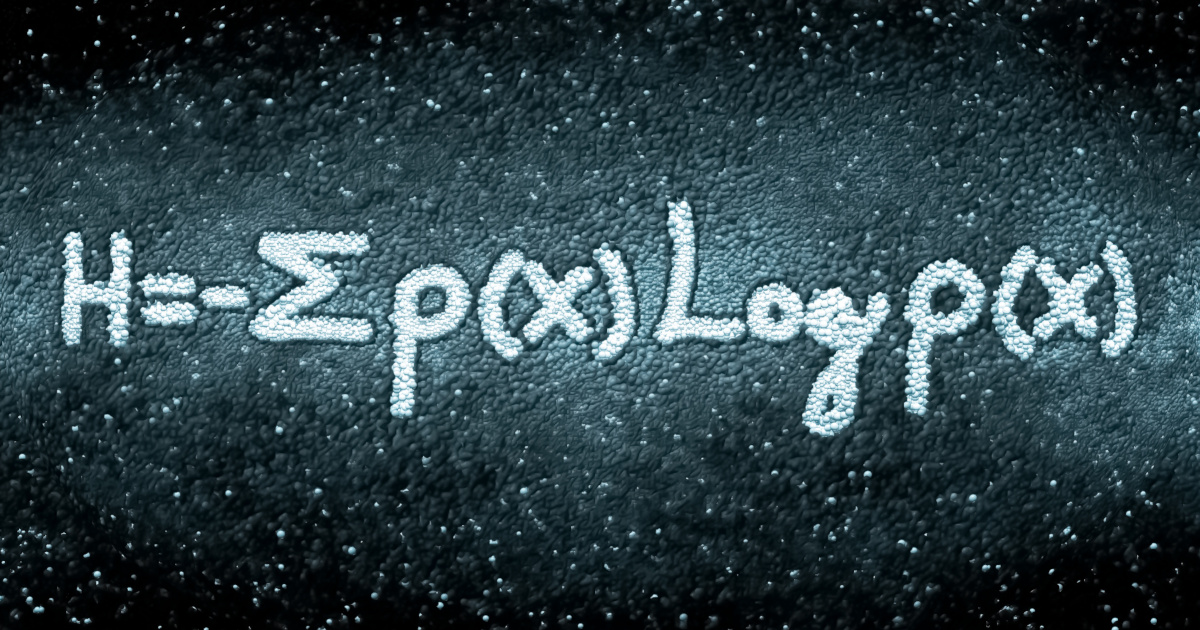

Formula per la quantità di informazione di Shannon

70 anni fa, nel 1948, sul Bell System Technical Journal, viene pubblicato un articolo dal titolo A mathematical theory of communication. L'autore è Claude Shannon, ingegnere elettrico e matematico statunitense, riconosciuto oggi come il padre della teoria dell'informazione. In questo articolo (uscito in due parti, a luglio e ottobre) viene per la prima volta introdotta l'unità di misura della quantità di informazione, il bit (binary digit), la stessa che utilizziamo oggi in tutti i nostri dispositivi elettronici (anche se parliamo di megabyte, gigabyte, terabyte).

Nel 1937, a soli 21 anni, Shannon si era laureato con una tesi che dimostrava che l'algebra booleana binaria poteva essere applicata a un circuito elettronico dotato di relay o commutatori. Questa tesi fu definita da alcuni “la più importante e più famosa tesi di laurea del XX secolo”: gettava le basi per il calcolo digitale.

Nel 1952 Shannon creò Theseus, un dispositivo che aveva le sembianze di un topo e che, inserito in un labirinto, apprendeva da solo come uscirne. Shannon può essere considerato anche uno dei padri dell'odierna intelligenza artificiale. L'informazione diventerà lo strumento matematico dietro la terza rivoluzione industriale, quella elettronica della seconda metà del '900, e dietro la quarta rivoluzione industriale, quella dell'automazione dei processi di produzione che stiamo vivendo oggi.

“L'informazione è informazione, non materia o energia. Al giorno d'oggi, nessun materialismo che non ammetta questo può sopravvivere”. Così scriveva Norbert Wiener in un altro lavoro pubblicato nel 1948, Cibernetica – controllo e comunicazione nell'animale e nella macchina, lasciando intendere che l'informazione, seppur inscindibile dal suo supporto materiale, è qualcosa di diverso da quest'ultimo. Materia ed energia sono unificate dall'equazione di Einstein, mentre l'informazione sfugge a questa classificazione.

La teoria dell'informazione fu accolta con molto entusiasmo dalla comunità scientifica e la funzione dell'informazione (o entropia) di Shannon fu impiegata in moltissimi campi. Nel 1953 Watson e Crick scoprirono la molecola a doppia elica del Dna e capirono, ispirati dalla teoria dell'informazione, che si trattava del codice della vita. L'informazione diventa uno strumento che uniforma fenomeni del mondo naturale e del mondo artificiale, descrivendoli come trasmissione di messaggi. In quegli anni, anche il computer stava compiendo i suoi primi passi.

"Shannon era al centro di un fermento intellettuale e direi anche filosofico relativo all'informazione e all'intelligenza artificiale. Una volta che il genio esce dalla bottiglia è difficile ricacciarlo dentro e in questo caso il genio è il concetto di informazione, il segnale che trasmette informazione". In questa intervista rilasciata a Il Bo Live, Giuseppe O. Longo discute dell'impatto che la teoria dell'informazione ha avuto sulla nostra società. Giuseppe O. Longo è informatico e scrittore, professore emerito di teoria dell'informazione all'università di Trieste. Ha tradotto per Adelphi tutte le opere di Gregory Bateson, e altri importanti lavori come quelli di Douglas Hofstadter e Daniel Dennett (L'io della mente) e di Marvin Minsky (La società della mente), libro per il quale gli è stato assegnato il premio Monselice per la traduzione, nel 1991. Oltre che di saggi e articoli, è autore di romanzi e di opere teatrali.

Intervista a Giuseppe O. Longo sulla teoria dell'informazione di Claude Shannon