Dilemmi morali per le auto a guida autonoma

A marzo di quest'anno, in Arizona, un'automobile a guida autonoma ha investito e ucciso una donna mentre attraversava la strada. Si tratta del primo incidente stradale mortale in cui è coinvolta un'intelligenza artificiale. L'auto era di proprietà di Uber, azienda simbolo della sharing economy nel settore del trasporto privato, che assieme ad altre compagnie come Tesla o Google sta sperimentando l'impiego di veicoli automatici sulle strade degli Stati Uniti, con la convinzione che un giorno questo aumenterà la sicurezza stradale.

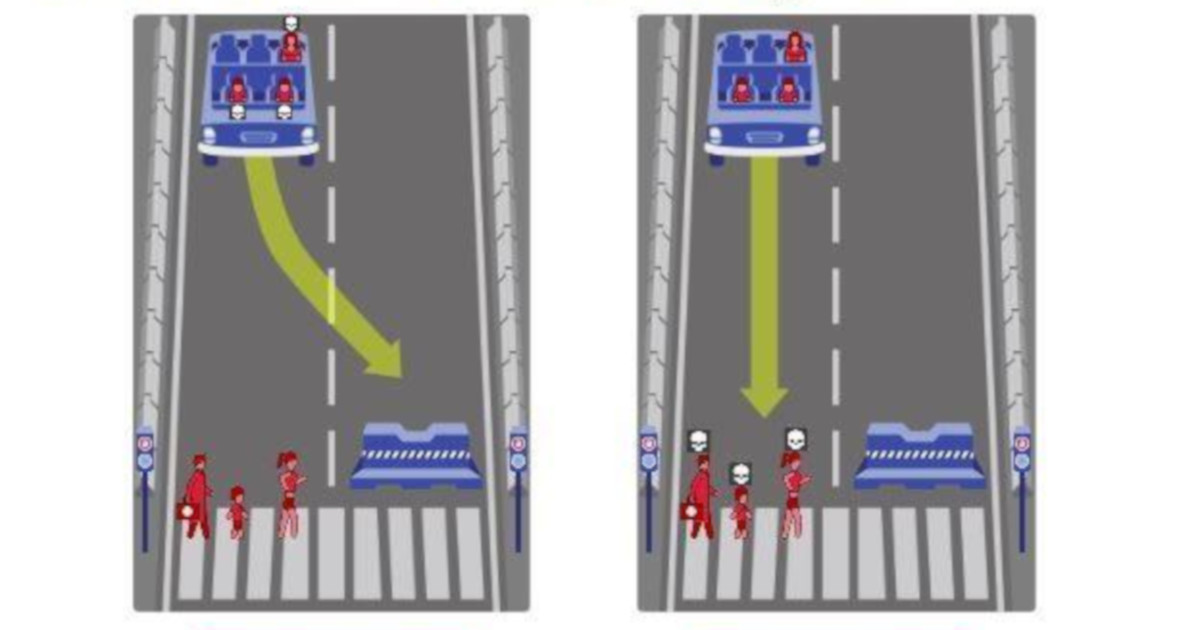

La quarantanovenne Elaine Herzberg stava attraversando la strada al di fuori delle strisce pedonali e i sistemi di sicurezza dell'auto non sono riusciti a riconoscerla. L'evento è stato tragico, ma, paradossalmente, sarebbe potuto esserlo ancora di più. Riconosciuto il pericolo, in una frazione di secondo, l'auto avrebbe dovuto compiere una scelta: agire in modo da salvare la vita del pedone o quella del passeggero, ma non entrambe.

Video rilasciato dalla polizia di Tempe, Arizona, relativo all'incidente mortale che ha coinvolto un'auto a guida autonoma

Il 24 ottobre scorso su Nature è stato pubblicato The Moral Machine Experiment, il più grande sondaggio mai effettuato sull'etica che dovrebbe informare le decisioni di un'intelligenza artificiale alla guida di un auto. I risultati dello studio hanno mostrato che i principi morali degli uomini non sono universali, bensì variano a seconda della cultura, delle condizioni economiche e dell'area geografica di provenienza.

Il lavoro è stato compiuto da scienziati del Media Lab e dell'Institute for Data System & Society del Mit (Massachusets Institute of Technology), del dipartimento di biologia dell'evoluzione umana di Harvard, del dipartimento di psicologia dell'università della Biritish Columbia in Canada e della scuola di economia di Tolosa.

I partecipanti sono stati sottoposti a dilemmi morali di questo tipo: siete su un cavalcavia, vedete un carrello ferroviario sfrecciare senza freni verso cinque persone legate sui binari, se non sarà fermato le ucciderà. Acconto a voi c'è un uomo molto grasso, se lo spingete giù dal cavalcavia con la sua stazza fermerà il carrello: lui morirà ma così saranno salvate cinque vite. “Uccideresti l’uomo grasso? - Il dilemma etico del male minore” è il titolo di un libro del 2014, edito da Raffaello Cortina, di David Edmonds, divulgatore inglese di scienza e filosofia, formatosi all'università di Oxford e premiato più volte dalla Bbc. Domande come quella di Edmonds hanno impegnato i filosofi morali per oltre mezzo secolo, perché trovare una risposta coerente a questi dilemmi morali, così come alle tre leggi della robotica di Asimov, è molto più complesso di quanto non si possa credere.

Da "Uccideresti l'uomo grasso?" di David Edmonds.

— Raffaello Cortina Ed (@CortinaEditore) 10 gennaio 2018

La scheda: https://t.co/JD4r62RAqg pic.twitter.com/A3H0hpDWPT

Se la morale sia universale o se cambi a seconda delle culture è un dibattito di lunga data e il lavoro pubblicato su Nature lo ripropone in chiave moderna, attraverso l'etica delle vetture automatiche.

Uno studio pubblicato su Science già nel 2016 mostrava che le persone coinvolte preferivano un'auto a guida autonoma che protegga i pedoni, andando anche a danno del passeggero; ma dichiaravano anche che non avrebbero mai acquistato un automobile programmata in questo modo. Un risultato paradossale per l'autore di quello studio, Iyad Rahwan, che ha deciso allora di riunire un nuovo team di scienziati per creare un quiz da distribuire in lingue diverse tramite una piattaforma online. Nel giro di 18 mesi, 2,3 milioni di persone provenienti da 233 Paesi hanno preso parte al quiz e hanno effettuato un totale di 40 milioni di decisioni.

“ I risultati dello studio hanno mostrato che i principi morali degli uomini non sono universali, bensì variano a seconda della cultura, delle condizioni economiche e dell'area geografica di provenienza

L'esperimento della “macchina morale” ha sottoposto ai suoi partecipanti una serie di scenari in cui la morte di almeno un individuo era sempre inevitabile, mentre altri fattori potevano variare: si poteva scegliere di salvare un giovane a danno di un vecchio, una persona a danno di un animale, un pedone a danno di un passeggero, un gruppo a danno di un individuo, un ricco a danno di un povero, e viceversa. Sono stati poi inseriti personaggi come donne incinta, criminali o dottori. Ciascun partecipante ha completato una sessione di 13 scenari possibili e alla fine poteva fornire una serie di dati personali come età, genere, istruzione, reddito, inclinazioni religiose e politiche. Quasi 500.000 persone hanno fornito questi dati.

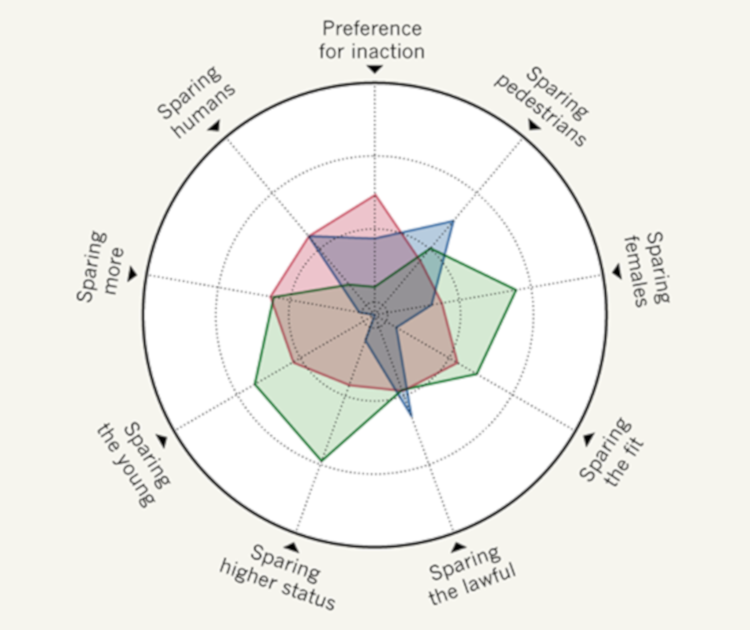

I risultati hanno mostrato che esistono alcuni principi morali sostanzialmente condivisi da tutto il campione: salvare gli umani a danno degli animali, salvare i gruppi e salvare le vite giovani. Un risultato significativo che potrebbe andare a costituire i mattoncini fondamentali dell'etica delle auto a guida automatica del futuro. E questo sembra anche essere in linea con le regole proposte dal report 2017 redatto dalla Commissione etica sulla guida automatica richiesto dal ministero dei trasporti e delle infrastrutture digitali del governo tedesco (unica direttiva governativa oggi a disposizione).

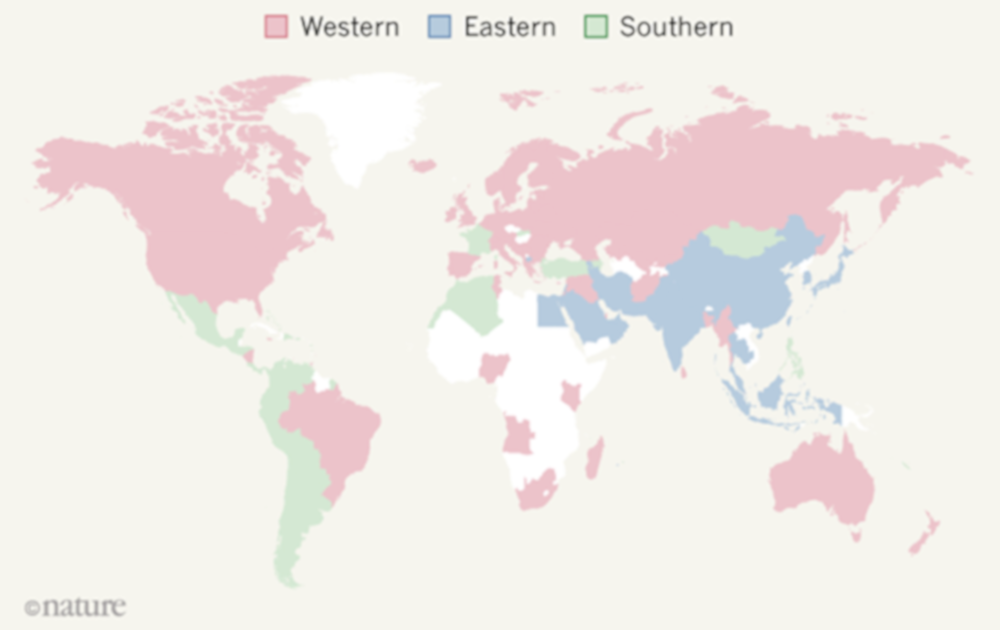

A fronte di questi pochi tratti condivisi, i ricercatori hanno registrato anche molta variazione nelle preferenze morali. Sono stati selezionati i 130 Paesi di cui si avevano almeno 100 partecipanti ed è emerso che Paesi vicini tendono a mostrare preferenze morali affini. I ricercatori hanno individuato a riguardo tre macro-gruppi distinti: un gruppo occidentale che racchiude il Nord America e molti Stati europei e altri Paesi in cui il Cristianesimo (cattolico, protestante e ortodosso) è stata la religione storicamente dominante; un altro gruppo orientale che riunisce Paesi come il Giappone, la Cina, l'Indonesia, l'Arabia Saudita e il Pakistan in cui il Confucianesimo o l'Islam hanno tradizionalmente dominato; un terzo gruppo, quello del sud, che vede riuniti l'America centrale e quella del sud insieme alla Francia e a ex colonie francesi.

I tre macro-gruppi individuati dallo studio: in rosso quello occidentale; in blu quello orientale; in verde quello del sud. Fonte: pagina Facebook Braingraph

Differenze significative sono emerse tra questi gruppi: il gruppo orientale ad esempio è meno incline a salvare vite giovani a danno di quelle anziane rispetto al gruppo del sud. I ricercatori hanno ipotizzato che la cultura e il livello economico di provenienza siano importanti fattori esplicativi: chi proviene da Paesi con forti culture individualistiche, come gli Stati Uniti o il Regno Unito, preferisce salvare un numero più alto possibile di vite individuali. Mentre coloro che provengono da culture in cui il rispetto per i membri anziani è più marcato mostrano una preferenza meno pronunciata nei confronti del salvataggio di vite giovani.

Il gruppo del sud, a differenza degli altri due gruppi, mostra una preferenza più debole verso il salvataggio di umani a danno degli animali; mentre mostra invece una forte preferenza nei confronti del salvataggio delle donne.

Altro dato interessante riguarda la correlazione tra solidità delle istituzioni e tolleranza dei comportamenti trasgressivi. I partecipanti provenienti da Paesi più poveri e con istituzioni più deboli sono più tolleranti nei confronti dei pedoni che attraversano fuori dalle strisce. mentre coloro che provengono da Paesi con istituzioni più stabili sono meno inclini a salvare il pedone che trasgredisce le regole.

I partecipanti provenienti da Paesi contraddistinti da un'ampia forbice di diseguaglianza economica mostrano un'altrettanto marcata differenza di trattamento degli individui ricchi e di quelli poveri (la disuguaglianza viene conservata). Allo stesso modo, un differente trattamento di uomini e donne si registra nei Paesi in cui è ampio il gender gap, mentre vengono trattate meglio le donne in quei Paesi in cui è migliore la loro condizione reale.

La "bussola morale": i tre gruppi differiscono sulle preferenze morali. Fonte: pagina Facebook Braingraph

In conclusione lo studio rivela che non esiste una morale universale riguardo a ciò che consideriamo giusto o sbagliato per quanto riguarda le decisioni che dovrebbero prendere le auto a guida automatica. Sebbene sia difficile stimare la frequenza con cui queste situazioni si presenteranno nella realtà, stabilire quali debbano essere i principi etici di una tecnologia con un'ampia prospettiva di diffusione è un tema che interessa non solo ingegneri ed esperti di etica, ma tutti i potenziali futuri consumatori. In altri termini, se le linee guida sull'etica dell'intelligenza artificiale venissero tracciate solo da esperti senza il coinvolgimento del grande pubblico, risulterebbero del tutto inutili.

Non è mai accaduto nella storia dell'umanità che si assegnasse a una macchina la responsabilità di decidere chi debba vivere o morire. Presto questo potrebbe accadere in uno degli ambiti più quotidiani della nostra vita: il trasporto privato. Lo studio rappresenta dunque anche un modo molto diretto per mettere la popolazione e i decisori politici a contatto con le problematiche che si celano dietro l'utilizzo su larga scala di tecnologie tanto innovative quanto delicate.