Un "firewall per la scienza": biblioteche e AI contro le riviste predatorie

Immagine generata dall'AI

Da più di un decennio la comunità scientifica internazionale si confronta con un fenomeno insidioso che minaccia la qualità della comunicazione accademica: le cosiddette riviste predatorie. Si tratta di pubblicazioni che, mascherandosi da legittimi periodici scientifici, offrono agli autori la possibilità di pubblicare articoli a pagamento senza garantire alcun processo di peer review rigoroso, né trasparenza sulle politiche editoriali. La loro proliferazione ha trovato terreno fertile nell’era dell’open access, sfruttando il modello “autore-paga” e approfittando delle pressioni sempre più forti cui i ricercatori sono sottoposti in termini di produttività scientifica. La nozione stessa di “predatory publishing” è stata introdotta nel 2009 dal bibliotecario Jeffrey Beall, che ne ha delineato i tratti principali in quella che divenne nota come la “Beall’s List”. Oggi il problema si è amplificato, assumendo connotazioni globali: colpisce in particolare contesti accademici emergenti, dove la pressione a pubblicare si intreccia con la scarsità di strumenti di valutazione e di formazione informativa.

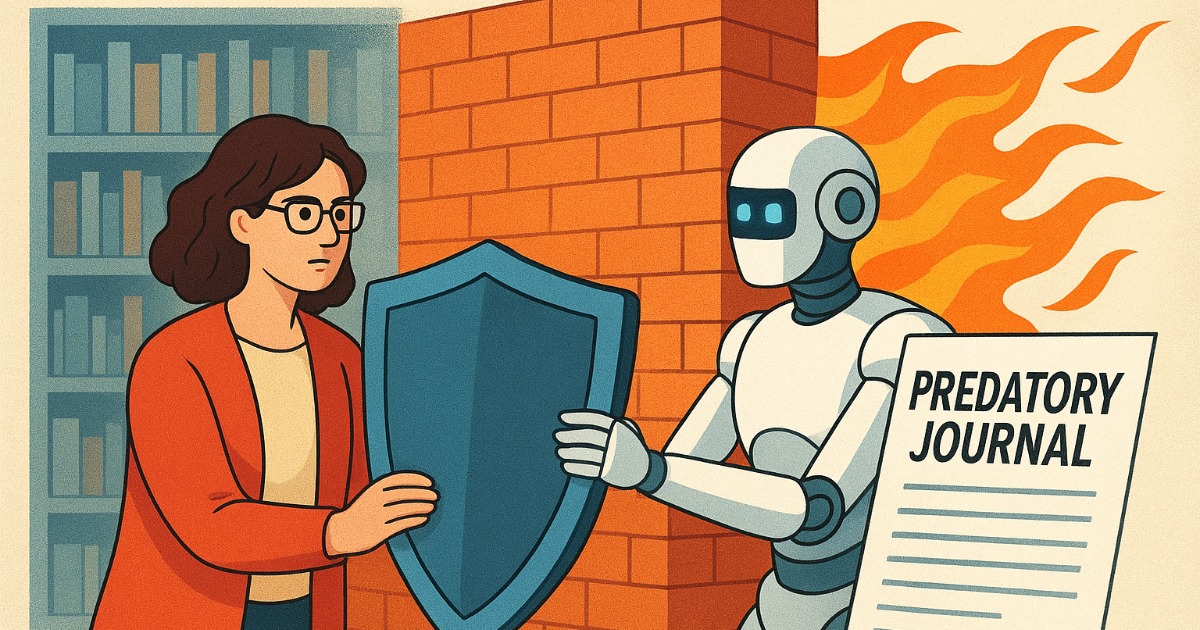

Il recente studio condotto dall’Università del Colorado Boulder, pubblicato su Science Advances, ha cercato di affrontare questo problema con un approccio innovativo: sviluppare uno strumento di intelligenza artificiale capace di analizzare automaticamente i siti web e i dati delle riviste scientifiche per individuarne le possibili anomalie. Il sistema sviluppato a Boulder non si limita a etichettare, ma fornisce indicatori leggibili, come l’eccessivo numero di articoli pubblicati o l’autocitazione sproporzionata da parte degli autori. Questa interpretabilità è cruciale per integrare l’AI nel lavoro bibliotecario, evitando l’automatismo cieco e rafforzando la responsabilità critica del professionista. L’AI è stata addestrata sui dati del Directory of Open Access Journals (DOAJ), storica risorsa che dal 2003 si impegna a distinguere le pubblicazioni affidabili da quelle sospette. Applicando i suoi algoritmi a oltre 15.000 riviste open access, la piattaforma ha segnalato inizialmente circa 1.400 testate come potenzialmente dubbie. Dopo la revisione umana, più di 1.000 sono rimaste nella lista delle “questionabili”. Il lavoro del team guidato da Daniel Acuña non pretende di sostituire il giudizio esperto di bibliotecari, ricercatori ed editori, ma si propone come uno strumento di pre-screening, capace di accelerare un compito altrimenti titanico. La metafora proposta dagli autori è quella di un “firewall per la scienza”: un filtro preliminare che riduca la possibilità che articoli privi di validazione si insinuino nel tessuto della comunicazione scientifica, contaminandolo.

Per i bibliotecari accademici, che da sempre hanno un ruolo cruciale nella mediazione dell’informazione, questa esperienza solleva questioni di grande rilevanza. Da un lato conferma la necessità di mantenere alta la vigilanza, continuando a educare studenti e ricercatori al riconoscimento delle pratiche editoriali scorrette. Le biblioteche universitarie sono da anni impegnate in attività di information literacy che includono anche la sensibilizzazione al fenomeno delle riviste predatorie, spesso facendo riferimento a repertori sviluppati entro i canali della scholarly communication, un ecosistema delicato che si fonda sulla fiducia reciproca, sul rigore della revisione tra pari e sulla cumulatività del sapere. Dall’altro lato, apre prospettive nuove: strumenti di intelligenza artificiale, se trasparenti e “interpretabili”, possono diventare alleati nel lavoro di selezione, classificazione e supporto alla ricerca. Se le fondamenta di questa torre crollano, l’intero edificio della scienza rischia di collassare.

L’esperienza dello studio del Colorado Boulder evidenzia anche un altro aspetto cruciale: la necessità di non delegare completamente alle macchine decisioni che hanno un forte impatto sulla comunità scientifica. Gli autori sottolineano come il loro algoritmo non sia infallibile: circa 350 riviste legittime erano state erroneamente etichettate come sospette. Questo margine di errore dimostra quanto sia fondamentale mantenere il ruolo del controllo umano, e quanto sia rischioso affidarsi a sistemi “black box” di cui non si comprendono le logiche interne.

Il problema delle riviste predatorie non è soltanto tecnico, ma culturale ed etico. Colpisce in particolare i contesti dove la pressione a pubblicare è più intensa e le risorse per una corretta formazione scientifica sono più scarse, come in molti Paesi emergenti in cui le istituzioni accademiche non hanno ancora consolidato procedure di valutazione robuste. In questi ambienti, la promessa di una pubblicazione facile e veloce, in cambio di una cifra che può variare da poche centinaia a qualche migliaio di dollari, diventa una trappola efficace. Per quanto riguarda Cina invece un articolo su Nature del marzo 2024 ha suscitato notevole interesse nella comunità scientifica internazionale, per la pubblicazione di una lista di riviste da tenere sotto sorveglianza dalla Biblioteca Nazionale dell’Accademia Cinese delle Scienze a Pechino, come riportato nel nostro articolo dello scorso anno. L’elenco annuale, noto come Early Warning Journal List (EWJL), aggiornato nel febbraio 2024, include 24 riviste e si concentra sulla cattiva condotta accademica e pratiche editoriali inadeguate. La lista, curata da Yang Liying e dal suo team, integra revisioni paritarie e analisi bibliometriche, permettendo agli studiosi di valutare con maggior precisione i rischi associati alla pubblicazione in determinate pubblicazioni. Il processo prevede raccolta di feedback, analisi di dati da Web of Science e dialogo con gli editori, riducendo l’elenco iniziale da circa 50 a 24 riviste nell’edizione 2024. Questa iniziativa nasce dalla crescente preoccupazione, anche in Cina, per il numero di articoli ritirati a causa di cattiva condotta accademica, fenomeno in forte crescita a livello globale.

Per le biblioteche accademiche lo scenario rafforza la necessità di assumere un ruolo attivo non solo nella conservazione e nell’accesso, ma anche nella vigilanza e nell’educazione critica. Qui si innesta il ruolo delle biblioteche accademiche. Da anni le linee guida IFLA (Principles for Open Access Scholarly Communication) e COPE (Committee on Publication Ethics) sottolineano la centralità della trasparenza, della corretta peer review e della chiarezza nei rapporti economici tra autori ed editori. Anche l’OASPA (Open Access Scholarly Publishers Association) ha elaborato un codice di condotta cui gli editori seri devono aderire, offrendo così strumenti concreti per distinguere pratiche virtuose da pratiche predatorie. Tuttavia, la rapida mutazione del fenomeno — un vero gioco del “whack-a-mole”, come osserva Acuña — rende difficile un controllo esclusivamente manuale.

Il compito per le biblioteche è dunque duplice: da un lato continuare a presidiare il campo con competenze documentarie e metodologiche, dall’altro integrare nel proprio lavoro gli strumenti più avanzati dell’analisi automatizzata, senza mai dimenticare il valore insostituibile del giudizio umano. Le biblioteche accademiche, presidio storico di qualità e filtro documentario, sono chiamate ad ampliare il loro raggio d’azione. Non si tratta solo di garantire accesso alle fonti, ma di educare alla valutazione critica delle stesse. Nei programmi di information literacy, la consapevolezza del fenomeno delle riviste predatorie è ormai un tassello imprescindibile: gli studenti e i giovani ricercatori devono essere in grado di riconoscere segnali di allarme — mancanza di informazioni sul processo di revisione, board editoriale opaco, linguaggio approssimativo, promesse di pubblicazione in tempi irrealisticamente rapidi.

Tutto questo in definitiva ci ricorda quanto la ricerca abbia bisogno di filtri affidabili, non solo tecnologici ma anche etici. La biblioteca accademica, tradizionalmente intesa come spazio di selezione e di garanzia della qualità informativa, trova in questa battaglia un terreno che la riguarda da vicino: diventare parte integrante del “firewall per la scienza”, un filtro etico, documentario e ora anche tecnologico, che protegga la comunità accademica dall’inquinamento. In questo panorama complesso l’alleanza tra intelligenza artificiale e bibliotecari potrebbe costituire davvero un nuovo capitolo nella difesa della scienza, a condizione che si mantenga sempre quella trasparenza che distingue la buona comunicazione scientifica dalla cattiva. Non si tratta di difendere un recinto chiuso, ma di promuovere un ecosistema aperto e sostenibile, dove l’open access non significhi abbassamento degli standard ma rafforzamento della fiducia.