Ogni anno a marzo in tutto il mondo si celebra la settimana dedicata al cervello. L'iniziativa è nata negli Stati Uniti nel 1996 da un gruppo di organizzatori che riuniva università, enti governativi e associazioni professionali ed è giunta oggi alla sua XXIII edizione. A Padova questa settimana siamo invece alla X edizione, che prenderà il via lunedì 11 marzo con l'incontro tra pubblico e giovani ricercatori in aula Nievo, e proseguirà con un ricco programma di eventi e lezioni tenute da docenti e ricercatori.

Tra questi, martedì alle 18 in Sala Anziani di Palazzo Moroni, Marco Zorzi, direttore del Computational Cognitive Neuroscience Lab del Dipartimento di Psicologia Generale e del Padova Neuroscience Center, parlerà dei recenti sviluppi e delle implicazioni etiche e sociali dell'Intelligenza Artificiale.

Professore, a che punto stanno gli studi sull'Intelligenza Artificiale?

Allo stato dell'arte il modello di Intelligenza Artificiale (IA) che funziona meglio è quello che si ispira al funzionamento del cervello, che utilizza le cosiddette reti neurali e il deep learning.

Come funziona il deep learning?

Per deep learning intendiamo quel processo di apprendimento in reti neurali profonde che sta alla base dei più recenti successi dell'IA applicata a problemi di riconoscimento di immagine, riconoscimento del parlato e altri ambiti che vediamo addirittura già implementati nei nostri smartphone. Il deep learning nasce nel 2006 e in questi ultimi anni c'è stato un boom nel suo sviluppo. Si è riusciti a fare apprendere reti neurali con molti strati di neuroni, cosa che prima non era considerata fattibile. Questo ovviamente ha aumentato in modo esponenziale la potenza computazionale di questi sistemi. Oggi si sente parlare di IA dappertutto, ma in realtà stiamo parlando dei successi che si sono avuti negli ultimi 10 anni con le reti neurali.

Oggi il termine IA è entrato nel vocabolario di tutti, ma è davvero intelligenza quella che vediamo?

In realtà la definizione di IA che utilizziamo correntemente è un po' lasca. All'inizio l'IA venne definita con il test di Turing: una macchina è intelligente nel momento in cui un umano non riesce a distinguere se sta comunicando con un umano o con una macchina. Oggi però il test di Turing non è considerato più un punto di riferimento indispensabile per stabilire l'intelligenza di una macchina. In realtà l'IA generale non esiste né sappiamo se ci arriveremo mai. Quello che veramente abbiamo a disposizione oggi sono sistemi di IA molto ristretti e focalizzati alla soluzione di un solo particolare problema per volta. Per questo parlare di vera e propria intelligenza è un po' esagerato. Diciamo che ci sono sistemi che dimostrano capacità che noi chiameremmo cognitive e che sono a un livello abbastanza paragonabile a quello umano, in alcuni casi forse addirittura superiori.

Prof. Marco Zorzi, Dipartimento di Psicologia Generale e Padova Neuroscience Center

Invece di IA allora non potremmo parlare di Cognizione Artificiale?

In un certo senso sì e infatti è un termine utilizzato molto anche a livello applicativo e ingegneristico: si parla di cognitive computing. Si utilizzano sistemi che hanno la capacità di svolgere un particolare compito come il riconoscimento vocale, che riconosce in modo sempre più accurato il linguaggio parlato. Questo però non implica che il sistema interpreti quello che ha ascoltato: il riconoscimento vocale è una cosa, l'interpretazione semantica un'altra. Quindi l'IA di oggi ha un approccio molto modulare: un sistema riconosce le parole, un altro le immagini e così via e già così si tratta di problemi sufficientemente complicati da risolvere, pensiamo ad esempio ai casi in cui ci sono più persone che parlano contemporaneamente oppure dei rumori di fondo! In queste situazioni gli umani continuano a essere di molto superiori. Però siamo arrivati al punto in cui la dettatura di un messaggio allo smartphone risulta molto accurata. Fino a 10 anni fa, prima del deep learning, una dettatura vocale aveva un errore ogni quattro parole. Ora siamo al di sotto di un errore ogni 10 parole.

Chi sta lavorando allo sviluppo di questi sistemi?

I grandi player dell'IA sono Google e tutti gli altri grandi nomi dell'informatica e dell'Hi Tech, Microsoft, Apple, Amazon. Ciascuno ha sviluppato i propri software di assistenti vocali: Siri, Google Assistent, Cortana, Alexa. Ibm sta puntando molto sulle applicazioni dell'IA, recentemente ha promosso l'idea che è necessario rendere i sistemi di IA più interpretabili e trasparenti, questo è uno dei grandi temi. Non possiamo utilizzarli come delle scatole nere, dobbiamo capire perché un sistema di IA suggerisce una certa decisione invece che un'altra.

Questo è il grande tema, aperto, di capire come apprende e “ragiona” una macchina?

Certo, perché esistono applicazioni, come il riconoscimento vocale, per le quali ci va bene conoscere solo il risultato finale, non è importante sapere come ci si arriva. Ma esistono altri problemi in cui è indispensabile sapere come apprende e cosa ha appreso una macchina, problemi che non interessano soltanto allo scienziato, ma anche alla gente comune perché coinvolgono questioni etiche. Oggi esistono già sistemi che con un bottone decidono, basandosi sui dati che forniamo loro, se si possa rilasciare un mutuo a una persona oppure no; decidono se a una persona che è stata in prigione può essere data la libertà vigilata oppure no. Se lei va in banca e un software intelligente le nega il mutuo immagino voglia sapere perché.

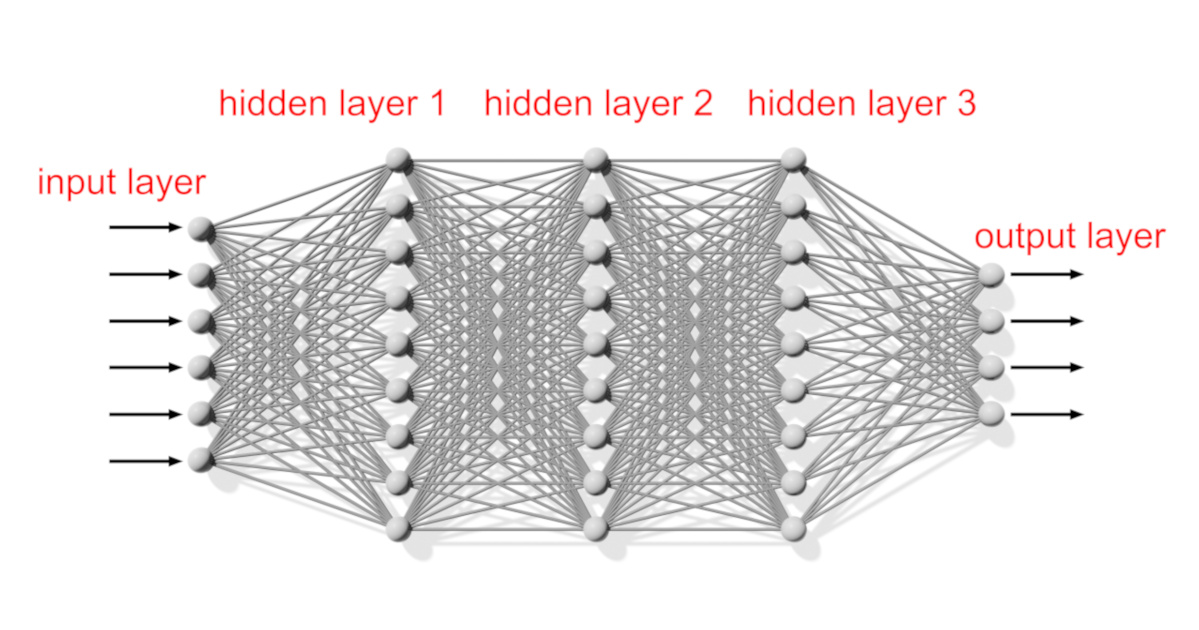

La rete neurale è un modello computazionale, ispirato alla rete neuronale biologica, composto di "neuroni" artificiali organizzati a strati (layer). Più sono gli strati, maggiore è la potenza computazionale.

Immagino dipenda da come viene formulato il problema alla macchina.

Certo, perché tutto l'apprendimento di questo tipo di sistemi si basa sulla conoscenza di un grandissimo numero di casi passati. Lei fornisce il suo profilo, e i dati del suo profilo vengono inseriti nella macchina. Paragonandoli ai dati passati la macchina generalizza la conoscenza pregressa sul caso nuovo. Così il sistema predice se lei sarà un buon pagatore o un cattivo pagatore. Questi sono temi già attuali anche da noi. Negli Stati Uniti hanno utilizzato un sistema per decidere se dare o meno la libertà vigilata ai detenuti, ma si è scoperto che il sistema era sbilanciato da un pregiudizio razziale contenuto nei dati: veniva valutata la propensione a ricommettere un crimine e una persona di colore aveva meno probabilità di ottenere la libertà vigilata perché i dati forniti alla macchina contenevano un storico che penalizzava le persone di colore. Il sistema non solo replicava ma amplificava un pregiudizio già presente nella società. Occorre risolvere questi problemi, rendere questi sistemi più trasparenti e interpretabili, un numero crescente di ricercatori li sta approfondando e di recente lo ha fatto anche l'Unione Europea. Se ci vogliamo fidare di questi sistemi dobbiamo conoscere molto a fondo il loro funzionamento.

Un recente lavoro fatto dall'MIT Technology review ha preso in considerazione più di 16.000 lavori pubblicati su arXive (archive) negli ultimi 25 anni per capire quali fossero i più importanti filoni di ricerca in ambito di IA. Hanno trovato che tra gli anni '90 e 2000 si è imposto il machine learning, negli anni 2000 il deep learning e adesso sta andando forte il reinforcement learning. Quali sono le differenze tra questi approcci?

Con machine learning si intendono tutti quei metodi e algoritmi che permettono a un software di apprendere dai dati, è una definizione molto generale di metodi che comprendono le reti neurali ma che non necessariamente c'entrano con il cervello, vengono inclusi metodi statistici e altri ancora.

Il deep learning è un metodo di machine learning che usa specificamente le reti neurali profonde, cioè reti di nuova generazione con molti strati di neuroni, una volta ci si limitava a 3 strati di neuroni, adesso abbiamo reti per il riconoscimento visivo che usano 10, 15, 20 strati.

La versione più recente di reinforcement learning si chiama deep reinforcement learning, parliamo sempre di reti neurali, ma qui il tipo di apprendimento cui viene sottoposta la macchina è diverso rispetto a quello andato per la maggiore negli ultimi 10 anni.

Nell'apprendimento per rinforzo viene definito un obiettivo dell'apprendimento ed il sistema tenta di raggiungerlo eseguendo delle azioni. Ad esempio, i ricercatori di Google Mind hanno sviluppato sistemi in grado di imparare il gioco del “Go”, un gioco da tavola più difficile degli scacchi, e di giocare ai vecchi videogiochi Atari. In questo caso il sistema riceve le stesse informazioni visive che riceverebbe un umano e le sue risposte sono le stesse che darebbe un umano, ovvero muovere un personaggio o una pedina per fare più punti possibile. Il sistema scopre quali risposte massimizzano la ricompensa, è la stessa situazione che avremmo nel condizionamento operante di Skinner.

La tipologia di apprendimento più utilizzata nella stragrande maggioranza dei lavori (70-80%) è comunque l'apprendimento supervisionato. Questo metodo associa un input (ad esempio un'immagine) a un output (un'etichetta che descrive quell'immagine): è un compito di categorizzazione molto ben definito e ha bisogno di una grande mole di dati.

Gruppo di ricerca del Prof. Zorzi al lavoro nel Computational Cognitive Neuroscience Lab

È possibile che il sistema umano sia un misto di tutti questi metodi messi assieme?

Assolutamente sì, è un misto. L'apprendimento supervisionato, nonostante sia molto impiegato negli studi di IA, in realtà è quello meno utilizzato nella nostra vita quotidiana. E infatti un altro tipo di apprendimento molto usato è quello dell'apprendimento non supervisionato (o generativo), qui il sistema semplicemente osserva i dati per estrarne le informazioni più importanti e impara a riprodurli a partire dalle rappresentazioni che ha costruito. .

In definitiva oggi l'IA dove sta andando?

Oggi l'IA replica in un certo senso un modello di mente che potremmo definire modulare, ciascun sistema sa svolgere molto bene un compito specifico (riconoscimento visivo o vocale) e questo di per sé non è sbagliato. Quello che veramente manca non solo a livello applicativo ma anche a livello neuroscientifico è capire come l'intelligenza generale possa emergere dall'interazione complessa tra tutti questi sistemi modulari e da altri sistemi che sono già dominio-generali, cioè che si occupano già di diversi compiti assieme. In neuroscienze si parla sempre di più di rete e di dinamiche whole brain che coinvolgono l'intero cervello, dell'interazione tra aree che non sono indipendenti ma che comunicano e partecipano a un dinamica estremamente più ricca e complessa rispetto a quella che si aveva in mente qualche anno fa.