Facebook ha un problema con la libertà di espressione. Gli utenti sono troppi, più di due miliardi, e ha già dimostrato di non saperla gestire. Che si tratti di immagini (celebri sono gli episodi del bacio di Rodin e della foto simbolo della guerra in Vietnam) o di parole, l'algoritmo non riesce a capire cosa deve cancellare e quali profili deve bloccare.

Del resto non è così facile: un bambino nudo rimane un bambino nudo, sia che lo posti un pedofilo sia che stia fuggendo da un bombardamento al Napalm, e forse manca ancora molto tempo al momento in cui l'intelligenza artificiale saprà distinguere le due cose.

Probabilmente prima o poi questo momento arriverà, perché per esempio nel caso di opere d'arte e foto storiche l'algoritmo potrebbe andare a pescare nelle banche dati per distinguere tra cultura e violazione, anche se poi si aprirà il dibattito sulle sculture in Das create e fotografate da un adolescente per fare il verso ai grandi del passato con statue nude homemade.

Perché purtroppo il problema non è banale, non si limita all'ambito artistico e si ripropone, ciclicamente, da anni: quali sono i limiti della libertà di espressione?

Per fare un esempio recente, trenta diverse organizzazioni hanno scritto una lettera aperta perché Facebook e Twitter starebbero cancellando sistematicamente alcuni post che documentano la situazione in Palestina, secondo criteri noti solo ai moderatori (figure evanescenti, cui accenneremo di seguito).

Di fatto, nonostante Facebook sia chiamato a stilare un rapporto sulla trasparenza, diciamo che non è decisamente il suo fiore all'occhiello: le decisioni sui post da cancellare vengono prese dall'intelligenza artificiale o dagli esseri umani, e non è nemmeno chiaro all'utente quale delle due entità sia responsabile nel singolo caso. Entrambe le opzioni, però, portano inevitabilmente a errori, che inizialmente venivano presi per danni collaterali in nome di un ambiente più sereno, ma in un secondo tempo il dissenso aveva cominciato a sfuggire di mano, rischiando di inficiare i risultati dell'attività degli advertiser, alla base del business di Facebook.

A questo punto è stato creato l’Oversight Board, un comitato indipendente che va ad analizzare le decisioni prese da Facebook, prima tramite l'intelligenza artificiale, e poi, eventualmente, con i moderatori. Il comitato è indipendente, nessuno manca mai di sottolinearlo, ma non bisogna dimenticare che è nato su istanza dello stesso Facebook.

Quali caratteristiche devono avere i suoi membri? Lo statuto lo spiega chiaramente: "I membri devono possedere e mostrare una vasta gamma di conoscenze, competenze, diversità ed esperienza. I membri non devono trovarsi in condizioni effettive o percepite di conflitto di interessi che potrebbero compromettere il loro giudizio indipendente e i processi decisionali. I membri devono aver dimostrato di avere esperienza nelle delibere effettuate in maniera responsabile e in quanto collaboratori dalla mentalità aperta all'interno di un team, di avere competenze nel prendere e spiegare le proprie decisioni in base a una serie di normative e di avere familiarità con gli argomenti relativi a contenuti e governance digitali, fra cui libera espressione, dibattito politico, sicurezza, privacy e tecnologia".

Oltre ai membri (almeno 11, ma l'intenzione sarebbe di arrivare a 40) ci sono i trustee, che controlleranno il loro operato.

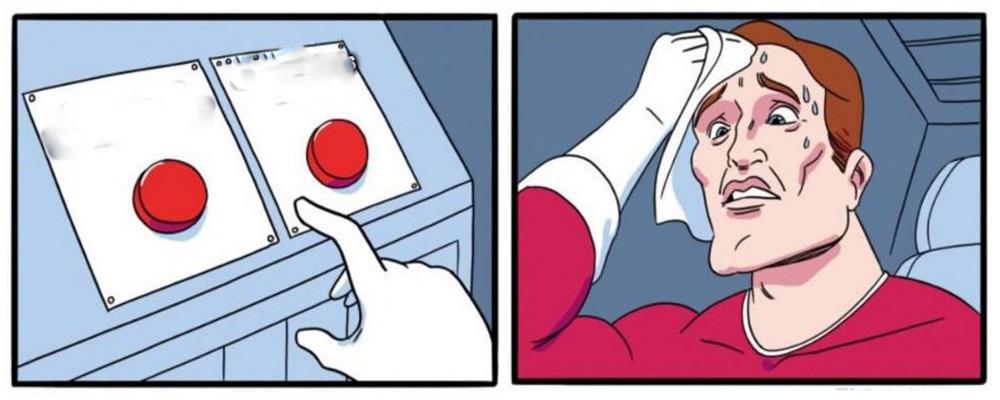

Apparentemente una botte di ferro: i membri hanno un curriculum di tutto rispetto e le decisioni prese fino a ora sono state coerentemente motivate. Il comitato, per esempio, è stato tirato in ballo per valutare la decisione di Facebook di sospendere i profili dell'ex presidente americano Donald Trump e, più di recente, ha espresso parere favorevole al diritto di satira: il meme incriminato rappresentava due bottoni, uno con la scritta: "Il genocidio armeno è una bugia" e l'altro “Gli Armeni erano terroristi che se lo meritavano”. La persona con i sudori freddi, chiamata a decidere tra queste due ipotesi in contraddizione, era rappresentata da una bandiera della Turchia: il senso è che la politica turca ha sempre assunto una posizione piuttosto schizofrenica sull'argomento (o il genocidio non esiste o è giustificato), e il meme, quindi, si inseriva perfettamente in un contesto satirico.

Dopo che il post era stato bloccato da due moderatori per due motivi diversi la questione è passata, appunto, all'Oversight Board: l'immagine era effettivamente annoverabile tra quei contenuti d'odio che troppo spesso, in realtà, continuano a sfuggire all'algoritmo, ma l'intento era satirico: si cercava, in altre parole, di stigmatizzare la posizione della Turchia sul genocidio armeno.

A partire da questo episodio, però, sono state date a Facebook varie indicazioni per prevenire problemi in futuro, e una è molto interessante: "Vanno adottate procedure per moderare contenuti satirici in modo da tenere conto del contesto. Ciò include fornire ai moderatori un accesso ai team operativi locali e dare abbastanza tempo per consultarsi con loro" e si continua auspicando che in questi casi si possa fare appello velocemente, se la decisione iniziale fosse quella di censurare il post.

A questo punto sorgono spontanee molte domande, destinate forse a rimanere senza risposta, visto che non sappiamo nel dettaglio come operino i moderatori di Facebook (entità tra l'altro non ben definite, come rileva la newsletter Guerre di rete del 23 maggio citando anche il libro Gli obsoleti. Il lavoro impossibile dei moderatori di contenuti di Jacopo Franchi): diamo per assodato che, allo stato attuale, nessuna AI sia in grado di valutare sistematicamente il livello di ironia o di satira di un post, e che dovrebbe quindi intervenire un essere umano: di che nazionalità? Sarebbe in grado un moderatore americano, per esempio, di capire che il meme sul genocidio andava a stigmatizzare la posizione irricevibile del governo turco? Verrebbe allora naturale chiamare in causa moderatori dello stesso paese, ma siamo sicuri che, se coinvolti così direttamente, sarebbero in grado di prendere una decisione ponderata? E, pur con tutta la buona volontà, il senso dell'ironia ha una componente soggettiva che potrebbe creare disparità tra due post simili.

Assume poi un ruolo chiave il fattore tempo: un essere umano, chiamato a decidere in fretta su questioni di questo tipo, probabilmente sarà più portato a cancellare un contenuto controverso, non avendo tempo di decidere sulla base di variabili di più difficile interpretazione come il contesto: un post di incitamento all'odio che diventa virale è probabilmente considerato più grave di un post leggermente sopra le righe che non vedrà invece mai la luce.

Nel complesso l'Oversight Board è una buona idea, ma non convince del tutto. Parliamo di una goccia nel mare, che rischia di avere un impatto decisionale soltanto nelle questioni politiche più importanti (per esempio ora è al lavoro per stabilire la liceità della cancellazione di alcuni contenuti critici nei confronti del governo cinese in seguito al colpo di stato in Myanmar, in questa pagina viene fatto un sunto di tutte le decisioni già prese). Per quanto poi il Board si impegni a fornire indicazioni utili anche per i post non strettamente connessi all'attualità, è difficile pensare che Facebook, grazie a esse, si ristrutturi dalle fondamenta: lasciare più tempo ai moderatori per decidere il destino dei post, per esempio, vorrebbe dire assumerne molti di più, e magari cercare lavoratori qualificati (attualmente, come spiega Franchi nel suo libro, non lo sono, e come se non bastasse dopo qualche mese di lavoro non ce la fanno più e scappano). Le decisioni del Board per statuto devono essere messe in pratica da Facebook, a meno che esse non violino la legge. Ma quali sarebbero le conseguenze se l'azienda puntasse i piedi e si rifiutasse? L'indignazione pubblica e nulla più, perché il Board, pur essendo indipendente, è stato istituito da Facebook, e non ha poteri sanzionatori.

O magari questo è un primo passo, che darà inizio a un'era di trasparenza e coerenza nelle decisioni della piattaforma. Forse suona un po' troppo bello, ma non è detto che un mondo migliore non possa cominciare proprio dai social.