Finora ci siamo imbattuti in una serie di fatti riguardanti il clima che abbiamo definiti “certi”, nel senso che sono stati oggetto di misure precise (quindi soggette a un errore anch’esso quantificato) e sono in ogni momento verificabili. Sono quelli che Galileo Galilei chiamava “sensate esperienze”, esperienze realizzate con i sensi, senza le quali non c’è scienza.

“ Sono quelli che Galileo Galilei chiamava “sensate esperienze”, esperienze realizzate con i sensi, senza le quali non c’è scienza

Le “sensate esperienze”, tuttavia, sono condizione necessaria ma non sufficiente per produrre conoscenza scientifica. La scienza non è, infatti, riducibile a una mera collezione di fatti, per quanto verificabili e oggetto di misure precise. Oltre alle “sensate esperienze”, avrebbe sostenuto Galileo, occorrono le “certe dimostrazioni”: ovvero una teoria, una spiegazione coerente e solida in termini logici. E, possibilmente, matematici. Perché, sosteneva il toscano, l’universo fisico è un libro scritto nel linguaggio dei numeri e degli enti geometrici.

Una simile definizione va stretta ai moderni epistemologi. Ma prendiamola per buona, almeno in prima approssimazione. Precisando, però, che le “certe dimostrazioni” (le teorie scientifiche) anche se altamente matematizzate non sono una rappresentazione fedele della realtà. Sono “libere creazioni della mente umana”, sosteneva Einstein che però devono “salvare i fenomeni”. Ovvero spiegare in modo completo e coerente tutti i fenomeni noti. Nulla di più (ma anche nulla di meno). È possibile, quindi, che ci siano due o più teorie scientifiche diverse che spiegano gli stessi “fatti” noti.

Per esempio tra il 1916 e il 1919 erano in campo due teorie fisiche diverse in grado di spiegare i “fatti” noti inerenti la gravità: la teoria della gravitazione universale di Newton e la teoria della relatività generale di Einstein. Proprio cento anni fa un’osservazione – un fatto “certo” in senso epistemologico – da parte di Arthur Eddington ha consentito di verificare che la teoria di Newton “non lo salvava”, mentre quella di Einstein sì. Ne abbiamo ricavato che quella di Einstein è una teoria più generale, l’unica in grado di “salvare” tutti i fenomeni gravitazionali noti. A tutt’oggi è la migliore teoria della gravitazione che abbiamo. Anche se lo stesso Einstein era convinto che dovrà essere superata.

La nostra breve discussione epistemologica riguarda anche le scienze del clima. E le teorie che ne spiegano la dinamica.

La teoria dell’”effetto serra”

Veniamo, dunque, al clima. Per salvare i fatti noti che lo riguardano sono state elaborate molte teorie. La più nota è quella del greenhouse effect, dell’effetto serra. Non è (o, almeno, non possiamo dire che sia) una rappresentazione fedele della realtà. Al contrario, vi possono essere, in linea di principio, altre teorie che salvano meglio i fenomeni climatici noti. A tutt’oggi, però, quella dell’effetto serra è “la teoria più economica”, insomma, la migliore che abbiamo.

Anche se ne sentiamo parlare solo da due o tre decenni, non è una teoria moderna. Risale addirittura al 1896, quando il chimico svedese Svante Arrenhius elabora, per l’appunto, una teoria per spiegare quei fatti, ormai noti ed eclatanti, del clima che sono i cicli di alternanza tra ere glaciali ed ere interglaciali. Cosa poteva aver provocato quei formidabili cambiamenti del clima?

Arrenhius è un abile spettroscopista e conosce bene la letteratura scientifica esistente sulle proprietà chimico-fisiche dell’acqua e dell’anidride carbonica. Così inizia a misurare la capacità di assorbimento della radiazione infrarossa della CO2 e del vapor acqueo presenti in atmosfera. D’altra parte sa bene che, come impongono le leggi termodinamiche elaborate proprio nel XIX secolo, un qualsiasi oggetto che assorbe energia aumenta la sua temperatura. Così giunge a elaborare la sua teoria: la presenza di CO2 e di vapor acqueo che assorbono energia infrarossa fa aumentare la temperatura atmosferica. I due gas producono un “effetto serra”, appunto.

La termodinamica impone che ci sia una corrispondenza specifica tra assorbimento dell’energia e aumento della temperatura. Poiché la quantità di radiazione assorbita dalle molecole di CO2 e di H2O è misurabile, è possibile ricavare con precisione l’aumento di temperatura che ne deriva.

Arrenhius elabora un’equazione matematica relativamente semplice che mette in relazione l’assorbimento di energia da parte di CO2 e di H2O e la temperatura atmosferica.

Sulla base della sua teoria fisica matematizzata, Arrenhius è in grado di effettuare una previsione precisa: un aumento con progressione geometrica della concentrazione di anidride carbonica in atmosfera determina un aumento in progressione aritmetica della temperatura. Tradotto dal gergo matematico significa che, ogni volta che la concentrazione di CO2 raddoppia, la temperatura atmosferica aumenta di un certo valore costante. Arrenhius è anche in grado di calcolare questa costante: il raddoppio della CO2 fa aumentare la temperatura di 5 o 6 °C. In seguito, rifatti i calcoli e preso in considerazione l’effetto prodotto dalla variazione di concentrazione del vapor acqueo, lo svedese abbassa di circa 2 °C la sua previsione: un raddoppio della CO2 determina un aumento della temperatura in atmosfera di 3 o 4 °C. Questo valore, sia detto per inciso, non è molto lontano da quello calcolato, in tempi più recenti, dagli scienziati dell’IPCC e compreso tra 2 e 4,5 °C.

Da notare che la teoria di Arrenhius implica che l’aumento della CO2 possa essere causa sufficiente per l’aumento della temperatura dell’atmosfera.

Le previsioni del chimico svedese non si fermarono qui. Egli sa che l’uomo è un attore ecologico globale e che ha influenza sul clima. Così calcola, per così dire, l’impronta umana sul clima: l’uso di combustibili fossili nelle industrie (che allora è essenzialmente uso di carbon fossile) avrebbe portato l’umanità a raddoppiare la concentrazione di CO2 nel giro di 3.000 anni. Oggi, che i ritmi di emissione sono cambianti, si calcola che il raddoppio rispetto ai valori dell’era pre-industriale possa avvenire nel giro non di qualche millennio, ma di qualche anno.

A differenza della nostra odierna percezione, Arrenhius considera desiderabile questa capacità di intervento sul clima globale da parte dell’uomo, perché – dice – grazie alla tecnica possiamo scongiurare un eventuale ritorno per cause naturali all’era glaciale.

“ Un qualsiasi oggetto che assorbe energia aumenta la sua temperatura

Il modello climatico che Svante Arrenhius utilizza è molto semplice. Dunque, abbastanza lontano dalla realtà. Non tiene conto fino in fondo della fluidodinamica, dei cicli astronomici a iniziare dalla rotazione della Terra sul proprio asse, del ruolo delle nubi, del ruolo degli oceani, dalla biosfera, dei cicli naturali del carbonio, del metano e dell’acqua. Né avrebbe potuto. Tener conto di tutti questi fattori comporta risolvere una quantità di equazioni enormi. E poiché ai tempi di Arrenhius i conti sono fatti a mano, il calcolo dell’evoluzione del clima sulla base di modelli più realistici e dunque più complessi, sia pure possibili in linea di principio, risultano impossibili in linea di fatto.

Il modello di Arrenhius applicato all’intero pianeta Terra ha un altro difetto, tipico dei grandi sistemi unici. Non è ripetibile in laboratorio. Dunque la teoria non è falsificabile. Se non in tre modi. O aspettando che la concentrazione di CO2 raddoppi davvero e verificando come si comporta la temperatura. O applicando la teoria al passato e verificando come è variata la temperatura al variare della concentrazione di CO2: ma ai tempi di Arrenhius non si poteva misurare né la temperatura né la concentrazione di CO2 del passato. Oppure applicare la teoria a un sistema analogo. Per esempio al sistema climatico di Venere o di Marte. Ma nessuno, un secolo fa, aveva un’idea precisa dell’organizzazione di quei sistemi.

Insomma, occorre aspettare tempi migliori per una verifica.

Ma intanto con Arrenhius il clima è diventato un problema scientifico in senso stretto. Ha i suoi fatti certi o accertabili, ha la sua teoria, ha precise regole di corrispondenza tra teoria e fatti, è in grado di elaborare delle previsioni.

I modelli del clima

Il tempo passa e un nuovo scenario, per certi versi inatteso, si apre con l’arrivo del computer. Con la sua enorme capacità di calcolo, l’elaboratore elettronico rende possibile affrontare problemi che in passato sono stati considerati intrattabili. Compreso il problema “evoluzione del clima”.

Non è un caso che sia proprio un climatologo, Edward Lorenz, a riscoprire all’inizio degli anni ’60 nel mondo fisico quel “caos deterministico” descritto dai matematici francesi Henri Poincaré e Jacques Hadamard ai tempi di Arrenhius. Il “caos deterministico” governa l’evoluzione di sistemi estremamente sensibili alle condizioni iniziali. Lorenz sta studiando il sistema clima. E il suo computer gli dice che si tratta, per l’appunto, di un sistema caotico, estremamente sensibile alle condizioni iniziali. Basta cambiare di una frazione minuscola uno solo dei parametri perché il sistema evolva in maniera completamente diversa. «Basta il battito d’ali di una farfalla in Amazzonia – sostiene lo scienziato americano – per scatenare una tempesta inattesa in Texas».

La metafora – che è destinata, a ragione, a diventare il motto della scienza dei sistemi complessi – rende bene la difficoltà di prevedere l’evoluzione del clima. Ma è anche vero che con il computer, con i satelliti, con una rete sempre più stretta di sensori sparsi per il pianeta a raccogliere dati, con l’elettronica e lo sviluppo in generale delle scienze quello di prevedere l’evoluzione del sistema complesso clima è diventato un “problema trattabile”. Tutto da risolvere, certo. Ma trattabile.

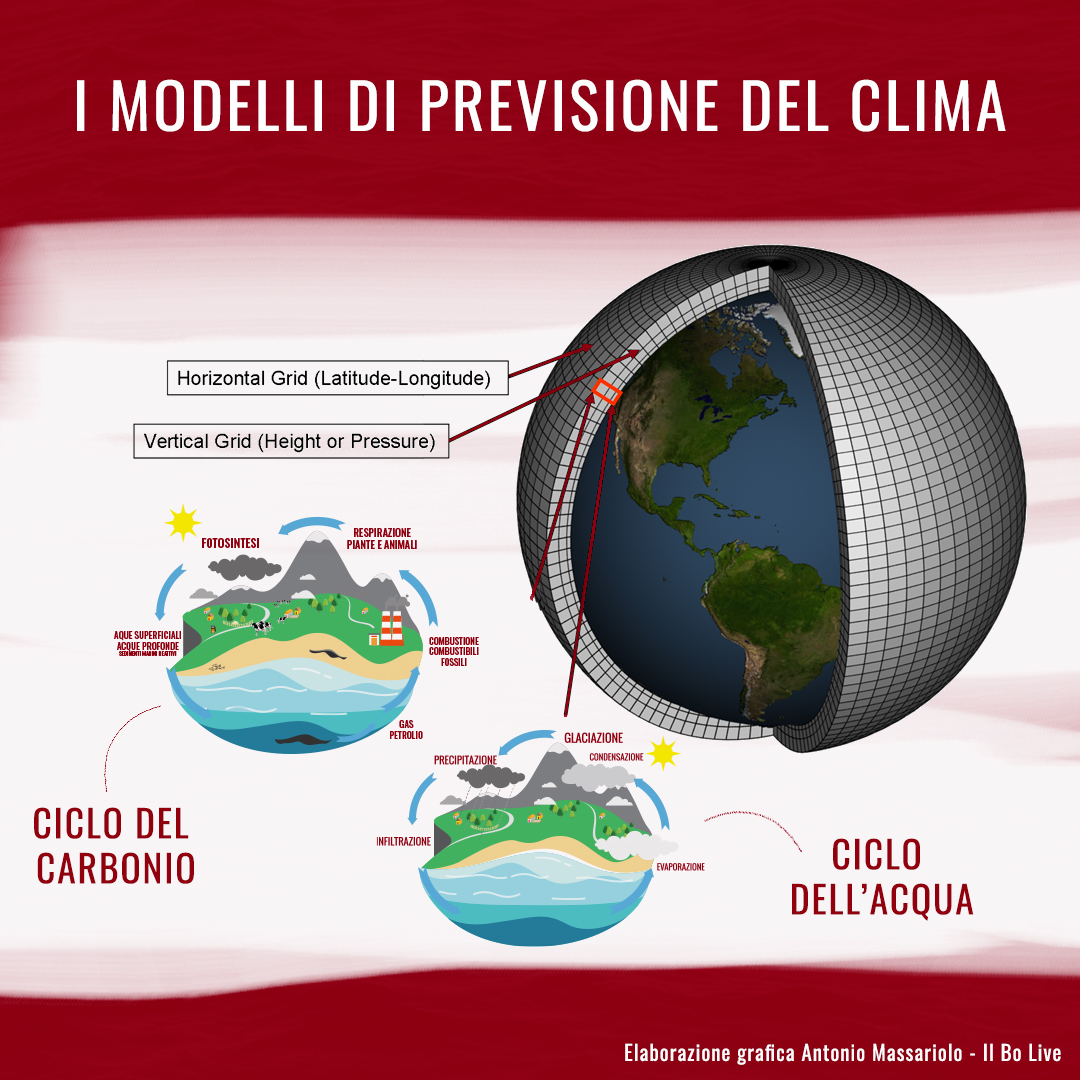

E infatti tra gli anni ’50 e ’60 del secolo scorso nascono i primi General Circulation Models (GCM): i modelli di circolazione globale, che fanno riferimento a consolidate teorie scientifiche (la termodinamica, la fluidodinamica, la chimica) e sono dotati di robusti algoritmi per calcolare sia come i gas circolano in atmosfera, con gli Atmospheric General Circulation Models (AGCM), sia come le acque circolano negli oceani, con gli Oceanic General Circulation Models (OGCM). I modelli si basano sulle “equazioni di Navier–Stokes”, messe a punto già nel XIX secolo da Claude-Louis Navier e da George Gabriel Stokes per descrivere la termodinamica dei fluidi.

I modelli di circolazione generale rappresentano un grosso passo avanti rispetto al semplice modello di Arrenhius. Perché tengono conto sia che la Terra è una sfera che ruota su sé stessa (e questo ha implicazioni sulla circolazione dall’aria), sia che il clima è un sistema alimentato da diverse fonti energetiche: la radiazione solare e il calore latente, in primo luogo.

In termini matematici significa sviluppare sistemi di “equazioni di Navier–Stokes” con un numero di parametri sempre più alto e con dati empirici sempre più precisi. Si tratta di sistemi di equazioni differenziali che applicano le leggi note della fisica, del moto dei fluidi e della chimica a celle tridimensionali. Per quanto riguarda l’atmosfera, per esempio, la si divide in tante celle tridimensionali distribuite lungo le direzioni di longitudine, latitudine e altezza. Per ciascuna di queste celle (che ora sono quadrati con un lato di poco più di 80 chilometri) si studia l’evoluzione. Poi si fa la somma. In una cella vengono presi in considerazioni parametri come la temperatura di partenza, la pressione, i venti, la radiazione, il trasferimento di calore, l’umidità relativa, l’idrologia di superficie. Inoltre si tiene conte delle interazioni con le celle vicine.

Lo sviluppo più semplice è quello di studiare celle sempre più piccole. In termini tecnologici, significa utilizzare computer sempre più potenti.

Uno dei grandi problemi ancora oggi non semplici da affrontare è l’accoppiamento tra atmosfera, oceani e terre emerse.

Il primo modello di circolazione generale della troposfera è realizzato, nel 1956, dall’americano Norman Phillips ed è utilizzato per le previsioni meteorologiche a una scala temporale che non va oltre il mese o un’intera stagione. Con tutte le possibilità di errori che, chi segue le previsioni del tempo alla radio e alla televisione, ha modo di valutare.

Occorre attendere, invece, il 1969 perché il primo GCM venga applicato allo studio dell’effetto serra e della sua evoluzione. L’impresa riesce a Syukuro Manabe e a Kirk Bryan del Geophysical Fluid Dynamics Laboratory che la NOAA – la National Oceanic and Atmospheric Administration, l’agenzia scientifica americana che studia, per l’appunto, l’atmosfera e gli oceani – ha attrezzato a Princeton, nel New Jersey.

Nel 1975 lo stesso Syukuro Manabe con Richard Wetherald pubblicano un articolo sul Journal of Atmospheric Sciences considerato, ormai, una pietra miliare nella storia degli studi sul clima in cui prendono in esame il problema di Arrenhius e simulano, con il primo GCM tridimensionale, cosa sarebbe successo in caso di raddoppio della concentrazione di CO2. Per la cronaca, i due scienziati calcolano un aumento della temperatura media alla superficie di 2,93 °C. Un dato molto vicino a quello che oggi viene considerato realistico e non molto lontano da quello calcolato da Svante Arrenhius.

Intanto i computer diventano più potenti e i modelli più raffinati. Nel corso degli anni ’80 l’Hadley Centre for Climate Change in Gran Bretagna sviluppa il Community Atmosphere Model, che nella sua terza versione nota come Hadley Centre Coupled Model, l’HadCM3, viene utilizzato dall’IPCC per elaborare il suo terzo rapporto sui cambiamenti climatici, pubblicato nel 2001. Un analogo modello, il Geophysical Fluid Dynamics Laboratory Coupled Model, versione 2.X (GFDL CM2.X) viene sviluppato dalla NOAA negli Stati Uniti. Si tratta di modelli che per la prima volta “accoppiano”, ovvero tengono insieme, gli AGCM e gli OGCM: ovvero i modelli di circolazione generale dell’atmosfera e degli oceani.

Un passaggio, anche da un punto di vista matematico, niente affatto banale. Perché deve farsi carico di integrare quelle che in fluidodinamica si chiamano onde di gravità (gravity waves), i fenomeni che si verificano all’interfaccia tra due fluidi, come l’aria e l’acqua, di diversa densità. Le onde del mare sono il più classico, ma non il più banale esempio di gravity waves.

Oggi i modelli del clima globale non solo accoppiano atmosfera e oceano, ma tengono conto anche dei ghiacci marini e dei vari fattori, come la vegetazione, che sulle terre emerse prendono parte al sistema climatico. Lo sforzo è quello di giungere a integrare in maniera sempre più precisa e compiuta anche i grandi cicli biogeochimici del carbonio, del metano e degli altri gas serra. È solo con questi modelli che si possono elaborare scenari evolutivi affidabili non solo a scala globale, ma anche a scala regionale.

Una nuova scienza, simulante

Ma quanto sono affidabili questi modelli? Possiamo fidarci delle loro previsioni?

A queste domande possiamo fornire, per ora, due tipi di risposte. Una, per cosi dire, di ragion pratica. L’altra di ragion pura.

La critica di ragion pratica ci dice che l’unico modo per rispondere con certezza è quello di attendere che il tempo passi e verificare se le previsioni effettuate si realizzano. Aspettare il 2100 e verificare se le previsioni dell’IPCC per quella data si realizzano. Oppure aspettare che raddoppi la concentrazione di CO2 e verificare se e di quanto è aumentata la temperatura.

Il guaio è che il clima influenza la nostra vita e non possiamo permetterci il lusso di aspettare prima di prendere delle decisioni. Dobbiamo, entro certi limiti, fidarci dei modelli. Non è una fiducia cieca, tuttavia. Possiamo fare dei test. Verificare, per esempio, se il modello che gira nei computer è in grado di ricostruire, con sufficiente definizione di dettaglio, il clima del passato. Questi test esistono. E ci dicono che i GCM più avanzati, ormai, ricostruiscono bene i cambiamenti del clima degli ultimi 150 anni. Ciò non ci garantisce per il futuro. Ma certo corrobora l’affidabilità dei modelli.

In realtà, noi – con i computer e i modelli – possiamo fare e facciamo molto di più. Possiamo effettuare quelli che gli esperti chiamano hind-casting: simulazioni sul passato. E rispondere a domande tipo: cosa sarebbe successo se …

Cosa sarebbe successo se l’attività solare non fosse aumentata?

Cosa sarebbe successo se i vulcani non avessero eruttato?

Cosa sarebbe successo se i raggi cosmici non fossero giunti sulla Terra?

Con questo tipo di domande possiamo “pesare” l’influenza dei vari fattori, naturali e antropici. È quello che è stato fatto. La risposta è univoca. Eliminando i cambiamenti intervenuti in tutti i fattori naturali noti, i cambiamenti del clima non sarebbero stati significativamente diversi da quelli che si sono verificati. In particolare non sarebbe stato alterato l’aumento della temperatura, soprattutto nei tre ultimi decenni.

Al contrario, eliminando i fattori antropici e, in particolare, le emissioni antropiche di gas serra i cambiamenti del clima non si sarebbero verificati. La temperatura non sarebbe significativamente aumentata. Soprattutto negli ultimi due decenni.

Questo ci dicono le simulazioni al computer.

È interessante notare che di recente un climatologo italiano, Antonello Pasini, con la sua equipe di lavoro, ha realizzato la simulazione del passato con modelli completamente diversi e indipendenti dai modelli dinamici di circolazione – Pasini ha usato modelli, lo diciamo a beneficio degli esperti, a reti neurali di tipo data-driven, ovvero diretti dai dati – e ha ottenuto i medesimi risultati: il recente aumento di temperatura è dovuto praticamente per intero alle attività umane.

Un altro modo, pratico, per testare i modelli è applicarli ai pianeti vicini, Marte e Venere. Anche in questo caso la teoria dell’effetto serra introiettata nei GCM ci fornisce risultati molto simili a quelli verificati attraverso l’osservazione. Marte e Venere corroborano la teoria dell’effetto serra e i modelli al computer.

Veniamo, ora, alla critica in punta di ragion pura. I modelli al computer aprono a una novità di tipo epistemologico. Quando li facciamo girare essi non ci forniscono una nuova spiegazione: perché la teoria l’abbiamo fornita noi (diverso il discorso per i modelli di tipo Pasini). Né ci forniscono una prova sperimentale: perché, appunto, quelli che ci regalano sono dati virtuali. Al computer è nato – o, almeno, si è enormemente sviluppato – un nuovo modo di fare scienza: la scienza attraverso la simulazione.

I computer e i vari modelli simulano bene il passato del clima. Ma abbiamo fondate ragioni per dire che simulano bene anche il futuro del clima?

Secondo alcuni la simulazione è una dimensione utile, che tuttavia va considerata integrativa e non sostitutiva delle “certe dimostrazioni” e delle “sensate esperienze”. Ma non entriamo nel dibattito sull’epistemologia della “scienza simulante”. Diciamo solo che il futuro climatico descritto dai modelli al computer è un “futuro possibile”, anzi molto probabile, ma non è un “futuro certo”.

Le incertezze che lo riguardano, sempre in termini di critica della ragion pura, sono almeno tre: quelle che emergono dalla teoria, che potrebbe non essere ancora precisa; quelle che emergono dalla mancanza di conoscenza empirica; le incertezze, per così dire, intrinseche: per esempio noi non possiamo prevedere con esattezza quali saranno le decisioni dell’uomo, che tanto peso hanno (o, almeno, sembrano avere) sui cambiamenti del clima.

Ma, al netto di tutti questi limiti, quali sono le previsioni per il futuro?

L'articolo fa parte di uno speciale più ampio sui cambiamenti climatici.

LEGGI ANCHE:

- I dati del cambiamento climatico: aumentata la concentrazione di gas serra nell'atmosfera

- Il clima è già cambiato, e questi sono gli effetti

- Scoperta: il clima può cambiare e l'ha sempre fatto

- La coevoluzione tra clima e vita

- L’impronta umana sul clima

- I modelli di previsione del clima

- Il clima del futuro

- Il futuro è nelle nostre mani